Žč®žąú Žįėžā¨ žóźžĚīž†ĄŪäł Žč§žĚīžĖīÍ∑łŽě® žĚłÍ≥ĶžßÄŽä• žóźžĄú žßÄŽä•Ūėē žóźžĚīž†ĄŪäł (Intelligent agent)ŽäĒ ŪôėÍ≤Ş̥ žßÄÍįĀ ŪēėÍ≥†, Ž™©ŪĎúŽ•ľ Žč¨žĄĪŪēėÍłį žúĄŪēī žěźžú®ž†ĀžúľŽ°ú ŪĖČŽŹôŪēėŽ©į, ÍłįÍ≥Ą ŪēôžäĶ žĚĄ ŪÜĶŪēī ŽėźŽäĒ žßÄžčĚ žĚĄ žäĶŽďĚŪēėžó¨ žĄĪŽä•žĚĄ ŪĖ•žÉĀžčúŪā¨ žąė žěąŽäĒ žč§ž≤īžĚīŽč§. ž£ľžöĒ AI ÍĶźÍ≥ľžĄúŽď§žĚÄ žĚłÍ≥ĶžßĎ䕞̥ "žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė žóįÍĶ¨ ŽįŹ žĄ§Í≥Ą"Ž°ú ž†ēžĚėŪēėŽ©į, Ž™©ŪĎú žßÄŪĖ•ž†Ā ŪĖČŽŹôžĚī žßÄŽä•žĚė ŪēĶžč¨žěĄžĚĄ Íįēž°įŪēúŽč§.

žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė ž†ĄŽ¨łŪôĒŽźú ŪēėžúĄ žßĎŪē©žĚł žóźžĚīž†ĄŪčĪ AI AI žóźžĚīž†ĄŪäł ŽėźŽäĒ Žč®žąúŪěą žóźžĚīž†ĄŪäł ŽĚľÍ≥†ŽŹĄ Ūē®)ŽäĒ Ž™©ŪĎúŽ•ľ ž†ĀÍ∑Ļž†ĀžúľŽ°ú ž∂ĒÍĶ¨ŪēėÍ≥†, žĚėžā¨Í≤įž†ēžĚĄ ŽāīŽ¶¨Ž©į, žě•ÍłįÍįĄžóź ÍĪłž≥ź ŪĖČŽŹôžĚĄ ž∑®Ūē®žúľŽ°úžć® žĚī ÍįúŽÖźžĚĄ Ūôēžě•Ūēėžó¨ žÉąŽ°úžöī ŪėēŪÉúžĚė ŽĒĒžßÄŪĄł žóźžĚīž†ĄžčúŽ•ľ ÍĶ¨ŪėĄŪēúŽč§.[ 1]

žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ Žč®žąúŪēú Í≤ÉŽ∂ÄŪĄį Í≥†ŽŹĄŽ°ú Ž≥Ķžě°Ūēú Í≤ÉÍĻĆžßÄ Žč§žĖĎŪēėŽč§. ÍłįŽ≥łž†ĀžĚł žė®ŽŹĄž°įž†ąÍłį ŽėźŽäĒ ž†úžĖī žčúžä§ŪÖú žĚÄ žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎°ú ÍįĄž£ľŽźėŽ©į, žĚłÍįĄ žĚīŽāė ÍłįžóÖ , ÍĶ≠ÍįÄ , žÉĚŽ¨ľ ÍĶįÍ≥Ą žôÄ ÍįôžĚī ŽŹôžĚľŪēú Íłįž§ÄžĚĄ ž∂©ž°ĪŪēėŽäĒ Žč§Ž•ł žčúžä§ŪÖúŽŹĄ Žßąžį¨ÍįÄžßÄžĚīŽč§.

žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ Ž™©ŪĎúŽ•ľ ŪŹ¨Ūē®ŪēėŽäĒ Ž™©ž†Ā Ūē®žąėŽ•ľ ÍłįŽįėžúľŽ°ú žěĎŽŹôŪēúŽč§. žĚīŽď§žĚÄ žôĄŽ£Ć žčú žĚī Ūē®žąėžĚė ÍłįŽĆÄÍįížĚĄ žĶúŽĆÄŪôĒŪēėŽäĒ Í≥ĄŪöćžĚĄ žÉĚžĄĪŪēėÍ≥† žč§ŪĖČŪēėŽŹĄŽ°Ě žĄ§Í≥ĄŽźúŽč§.[ 3] ÍįēŪôĒ ŪēôžäĶ žóźžĚīž†ĄŪ䳎äĒ Ž≥īžÉĀ Ūē®žąėŽ•ľ ÍįÄžßÄÍ≥† žěąžĖī ŪĒĄŽ°úÍ∑łŽěėŽ®łÍįÄ žõźŪēėŽäĒ ŪĖČŽŹôžĚĄ ŪėēžĄĪŪē† žąė žěąŽč§.[ 4] žßĄŪôĒ žēĆÍ≥†Ž¶¨ž¶ė žĚė ŪĖČŽŹôžĚÄ ž†ĀŪē©ŽŹĄ Ūē®žąėžóź žĚėŪēī žēąŽāīŽźúŽč§.[ 5]

žĚłÍ≥ĶžßÄŽä•žĚė žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ Í≤Ĺž†úŪēô žĚė žóźžĚīž†ĄŪäł žôÄ ŽįÄž†ĎŪēėÍ≤Ć ÍīÄŽ†®ŽźėžĖī žěąžúľŽ©į, žßÄŽä•Ūėē žóźžĚīž†ĄŪäł ŪĆ®Žü¨Žč§žěĄ žĚė žó¨Žü¨ Ž≤Ąž†ĄžĚī žĚłžßÄ Í≥ľŪēô , žú§Ž¶¨Ūēô , žč§ž≤ú žĚīžĄĪ ž≤†ŪēôŽŅźŽßĆ žēĄŽčąŽĚľ ŽßéžĚÄ Ūēôž†úÍįĄ žā¨ŪöĆ žĚłžßÄ Ž™®ŽćłŽßĀ ŽįŹ žĽīŪď®ŪĄį žā¨ŪöĆ žčúŽģ¨Ž†ąžĚīžÖė žóźžĄú žóįÍĶ¨ŽźúŽč§.

žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ žĘÖžĘÖ žĽīŪď®ŪĄį ŪĒĄŽ°úÍ∑łŽě®Í≥ľ žú†žā¨Ūēú ž∂ĒžÉĀž†ĀžĚł ÍłįŽä• žčúžä§ŪÖúžúľŽ°ú ŽŹĄžčĚž†ĀžúľŽ°ú žĄ§Ž™ÖŽźúŽč§. žĚīŽ°†ž†Ā Ž™®ŽćłÍ≥ľ žč§ž†ú ÍĶ¨ŪėĄžĚĄ ÍĶ¨Ž≥ĄŪēėÍłį žúĄŪēī žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė ž∂ĒžÉĀž†Ā žĄ§Ž™ÖžĚÄ ž∂ĒžÉĀ žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎̾Í≥† Ž∂ąŽ¶įŽč§. žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ ŽėźŪēú žā¨žö©žěźŽ•ľ ŽĆÄžč†Ūēėžó¨ žěĎžó̥֞ žąėŪĖČŪēėŽäĒ žěźžú®ž†ĀžĚł žĽīŪď®ŪĄį ŪĒĄŽ°úÍ∑łŽě®žĚł žÜĆŪĒĄŪäłžõ®žĖī žóźžĚīž†ĄŪäł žôÄ ŽįÄž†ĎŪēėÍ≤Ć ÍīÄŽ†®ŽźėžĖī žěąŽč§. žĚīŽď§žĚÄ ŽėźŪēú Í≤Ĺž†úŪēô žóźžĄú ŽĻĆŽ†§žė® žö©žĖīžĚł "Ūē©Ž¶¨ž†Ā žóźžĚīž†ĄŪäł "Ž°úŽŹĄ Ž∂ąŽ¶įŽč§.

žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė ÍįúŽÖźžĚÄ žĚłÍ≥ĶžßĎ䕞̥ ž†ēžĚėŪēėÍ≥† žĚīŪēīŪēėŽäĒ Žćį žěąžĖī ÍłįŽ≥łž†ĀžĚł Ž†Ćž¶ąŽ•ľ ž†úÍ≥ĶŪēúŽč§. žėąŽ•ľ Žď§žĖī, žėĀŪĖ•Ž†• žěąŽäĒ ÍĶźÍ≥ľžĄúžĚł žĚłÍ≥ĶžßÄŽä•: ŪėĄŽĆÄž†Ā ž†ĎÍ∑ľ (Žü¨žÖÄ & ŽÖłŽĻÖ)žĚÄ Žč§žĚĆÍ≥ľ ÍįôžĚī žĄ§Ž™ÖŪēúŽč§.

žóźžĚīž†ĄŪäł: ŪôėÍ≤Ş̥ žßÄÍįĀ(žĄľžĄú žā¨žö©)ŪēėÍ≥† Í∑łžóź ŽĒįŽĚľ ŪĖČŽŹô(žē°ž∂ĒžóźžĚīŪĄį žā¨žö©)ŪēėŽäĒ Ž™®Žď† Í≤É. žėą: žĻīŽ©ĒŽĚľžôÄ ŽįĒŪÄīÍįÄ žěąŽäĒ Ž°úŽīá, ŽćįžĚīŪĄįŽ•ľ žĚĹÍ≥† Í∂Ćžě• žā¨Ūē≠žĚĄ ž†úÍ≥ĶŪēėŽäĒ žÜĆŪĒĄŪäłžõ®žĖī ŪĒĄŽ°úÍ∑łŽě®.Ūē©Ž¶¨ž†Ā žóźžĚīž†ĄŪäł: žěźžč†žĚė žßÄžčĚÍ≥ľ Í≥ľÍĪį Í≤ĹŪóėžĚĄ ŽįĒŪÉēžúľŽ°ú žĶúÍ≥†žĚė ÍįÄŽä•Ūēú Í≤įÍ≥ľ Ž•ľ Žč¨žĄĪŪēėÍłį žúĄŪēī ŽÖłŽ†•ŪēėŽäĒ žóźžĚīž†ĄŪäł. "žĶúÍ≥†"ŽäĒ žĄĪŽä• žł°ž†ē(žóźžĚīž†ĄŪäłÍįÄ žĖľŽßąŽāė žěėŪēėÍ≥† žěąŽäĒžßÄŽ•ľ ŪŹČÍįÄŪēėŽäĒ Žį©Ž≤ē)žúľŽ°ú ž†ēžĚėŽźúŽč§.žĚłÍ≥ĶžßÄŽä• (Ž∂ĄžēľŽ°úžĄú): žĚīŽü¨Ūēú Ūē©Ž¶¨ž†Ā žóźžĚīž†ĄŪäłžĚė žóįÍĶ¨ ŽįŹ žÉĚžĄĪ.Žč§Ž•ł žóįÍĶ¨žěźŽď§Í≥ľ ž†ēžĚėŽď§ŽŹĄ žĚī ÍłįŽįė žúĄžóź ÍĶ¨ž∂ēŽźúŽč§. ŪĆ®ŽďúŪĖĄÍ≥ľ žúĄŽčąžĹĒŪĒĄŽäĒ žßÄŽä•Ūėē žóźžĚīž†ĄŪäłÍįÄ ŪôėÍ≤Ĺ Ž≥ÄŪôĒžóź žčúÍłįž†Āž†ąŪēėÍ≤Ć ŽįėžĚĎŪēėÍ≥†, Ž™©ŪĎúŽ•ľ ž†ĀÍ∑Ļž†ĀžúľŽ°ú ž∂ĒÍĶ¨ŪēėŽ©į, žú†žóįŪēėÍ≥† Í≤¨Í≥†Ūēīžēľ ŪēúŽč§(žėąžÉĀžĻė Ž™ĽŪēú žÉĀŪô©žĚĄ ž≤ėŽ¶¨Ūē† žąė žěąžĖīžēľ Ūē®)Í≥† Íįēž°įŪēúŽč§. žĚľŽ∂ÄŽäĒ žĚīžÉĀž†ĀžĚł žóźžĚīž†ĄŪäłÍįÄ Í≤Ĺž†úž†Ā žĚėŽĮłžóźžĄú "Ūē©Ž¶¨ž†Ā"(žĶúž†ĀžĚė žĄ†ŪÉ̞̥ Ūē®)žĚīžĖīžēľ ŪēėŽ©į, žč†ŽÖź, žöēÍĶ¨, žĚėŽŹĄ(BDI Ž™®Žćł )žôÄ ÍįôžĚÄ Ž≥Ķžě°Ūēú ž∂ĒŽ°†žĚī ÍįÄŽä•Ūēīžēľ ŪēúŽč§Í≥† ž†úžēąŪēėÍłįŽŹĄ ŪēúŽč§. žĻīŪĒĆŽěÄÍ≥ľ ŪēėžĚłŽĚľžĚłžĚÄ žôłŽ∂Ä ŽćįžĚīŪĄįŽ•ľ žĚīŪēīŪēėÍ≥†, Í∑ł ŽćįžĚīŪĄįŽ°úŽ∂ÄŪĄį ŪēôžäĶŪēėŽ©į, ŪēôžäĶŪēú Í≤ɞ̥ žú†žóįŪēú ž†ĀžĚϞ̥ ŪÜĶŪēī Ž™©ŪĎú Žč¨žĄĪžóź žā¨žö©ŪēėŽäĒ žčúžä§ŪÖúžĚė Žä•Ž†•žóź žīąž†źžĚĄ Žßěž∂ė žú†žā¨Ūēú ž†ēžĚėŽ•ľ ž†úžčúŪēúŽč§.

žĚłÍ≥ĶžßĎ䕞̥ žßÄŽä•Ūėē žóźžĚīž†ĄŪäł ÍīÄž†źžóźžĄú ž†ēžĚėŪēėŽäĒ Í≤ÉžĚÄ Ž™á ÍįÄžßÄ ž£ľžöĒ žĚīž†źžĚĄ ž†úÍ≥ĶŪēúŽč§.

ž≤†Ūēôž†Ā ŽÖľžüĀ ŪöĆŪĒľ: ŪäúŽßĀ Í≤Äžā¨ Žāė žĄ§žĚė ž§ĎÍĶ≠žĖī Žį© žóźžĄú ž†úÍłįŽźėŽäĒ Í≤Éž≤ėŽüľ žĚłÍ≥ĶžßÄŽä•žĚī "žßĄž†ēžúľŽ°ú" žßÄŽä•ž†ĀžĚłžßÄ ŽėźŽäĒ žĚėžčĚž†ĀžĚłžßÄžóź ŽĆÄŪēú ŽÖľžüĀžĚĄ ŪĒľŪēúŽč§. žĚīŽäĒ žĚłÍįĄžĚė žā¨Í≥†Ž•ľ Ž≥Ķž†úŪēėŽäĒ Í≤ÉžĚī žēĄŽčąŽĚľ ŪĖČŽŹôÍ≥ľ Ž™©ŪĎú Žč¨žĄĪžóź ž§Ďž†źžĚĄ ŽĎĒŽč§.ÍįĚÍīÄž†ĀžĚł ŪÖĆžä§Ūäł: AI žčúžä§ŪÖúžĚĄ ŪŹČÍįÄŪēėŽäĒ Ž™ÖŪôēŪēėÍ≥† Í≥ľŪēôž†ĀžĚł Žį©Ž≤ēžĚĄ ž†úÍ≥ĶŪēúŽč§. žóįÍĶ¨žěźŽď§žĚÄ ŪäĻž†ē "Ž™©ŪĎú Ūē®žąė" (ŽėźŽäĒ Ž™©ž†Ā Ūē®žąė)Ž•ľ žĖľŽßąŽāė žěė žĶúŽĆÄŪôĒŪēėŽäĒžßÄŽ•ľ žł°ž†ēŪēėžó¨ Žč§Ž•ł ž†ĎÍ∑ľ Žį©žč̞̥ ŽĻĄÍĶźŪē† žąė žěąŽč§. žĚīŽäĒ Íłįžą†žĚė žßĀž†Ďž†ĀžĚł ŽĻĄÍĶź ŽįŹ ž°įŪē©žĚĄ ÍįÄŽä•ŪēėÍ≤Ć ŪēúŽč§.Ūēôž†úÍįĄ žÜĆŪÜĶ: žąėŪēôž†Ā žĶúž†ĀŪôĒ ŽįŹ Í≤Ĺž†úŪēô Í≥ľ ÍįôžĚī "Ž™©ŪĎú" ŽįŹ "Ūē©Ž¶¨ž†Ā žóźžĚīž†ĄŪäł"žôÄ ÍįôžĚÄ ÍįúŽÖźžĚĄ žā¨žö©ŪēėŽäĒ Žč§Ž•ł Ž∂ĄžēľžĚė AI žóįÍĶ¨žěźŽď§žĚī ŪėĎŽ†•Ūē† žąė žěąŽäĒ Í≥ĶŪÜĶ žĖłžĖīŽ•ľ žÉĚžĄĪŪēúŽč§.

Ž™©ž†Ā Ūē®žąė (ŽėźŽäĒ Ž™©ŪĎú Ūē®žąė )ŽäĒ žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė Ž™©ŪĎúŽ•ľ žßÄž†ēŪēúŽč§. žóźžĚīž†ĄŪäłÍįÄ Ž™©ž†Ā Ūē®žąėžóź ŽćĒ žěė Ž∂ÄŪē©ŪēėŽäĒ Í≤įÍ≥ľŽ•ľ žāįž∂úŪēėŽäĒ ŪĖČŽŹôžĚĄ žĚľÍīÄŽźėÍ≤Ć žĄ†ŪÉĚŪē†žąėŽ°Ě ŽćĒ žßÄŽä•ž†ĀžĚīŽĚľÍ≥† ÍįĄž£ľŽźúŽč§. žā¨žč§žÉĀ Ž™©ž†Ā Ūē®žąėŽäĒ žĄĪÍ≥ĶžĚė ž≤ôŽŹĄ žó≠Ūē†žĚĄ ŪēúŽč§.

Ž™©ž†Ā Ūē®žąėŽäĒ Žč§žĚĆÍ≥ľ ÍįôžĚĄ žąė žěąŽč§.

Žč®žąúŪē®: žėąŽ•ľ Žď§žĖī, ŽįĒŽĎĎ Í≤ƞ쥞󟞥ú Ž™©ž†Ā Ūē®žąėŽäĒ žäĻŽ¶¨žóźŽäĒ 1, ŪĆ®ŽįįžóźŽäĒ 0žĚė ÍįížĚĄ Ūē†ŽčĻŪē† žąė žěąŽč§.Ž≥Ķžě°Ūē®: žóźžĚīž†ĄŪäłÍįÄ Í≥ľÍĪį ŪĖČŽŹôžĚĄ ŪŹČÍįÄŪēėÍ≥† ŪēôžäĶŪēėžó¨ Ūö®Í≥ľž†ĀžĚł Í≤ÉžúľŽ°ú žěÖž¶ĚŽźú ŪĆ®ŪĄīžĚĄ ÍłįŽįėžúľŽ°ú ŪĖČŽŹôžĚĄ ž°įž†ēŪēīžēľ Ūē† žąėŽŹĄ žěąŽč§.Ž™©ž†Ā Ūē®žąėŽäĒ žóźžĚīž†ĄŪäłÍįÄ Žč¨žĄĪŪēėŽŹĄŽ°Ě žĄ§Í≥ĄŽźú Ž™®Žď† Ž™©ŪĎúŽ•ľ ŪŹ¨Ūē®ŪēúŽč§. Ūē©Ž¶¨ž†Ā žóźžĚīž†ĄŪäłžĚė Í≤Ĺžöį, žě†žě¨ž†ĀžúľŽ°ú žÉĀž∂©ŪēėŽäĒ Ž™©ŪĎú ÍįĄžĚė ž†ąž∂©ž†źŽŹĄ ŪÜĶŪē©ŪēúŽč§. žėąŽ•ľ Žď§žĖī, žěźžú® ž£ľŪĖČ žį®ŽüČžĚė Ž™©ž†Ā Ūē®žąėŽäĒ žēąž†Ą, žÜ掏Ą, žäĻÍįĚ ŪéłžĚėžôÄ ÍįôžĚÄ žöĒžÜĆŽ•ľ Í∑†Ūėē žěąÍ≤Ć ž°įž†ēŪē† žąė žěąŽč§.

Žß•ŽĚĹžóź ŽĒįŽĚľ žĚī ÍįúŽÖźžĚĄ žĄ§Ž™ÖŪēėÍłį žúĄŪēī Žč§žĖĎŪēú žö©žĖīÍįÄ žā¨žö©ŽźúŽč§. žó¨ÍłįžóźŽäĒ Žč§žĚĆžĚī ŪŹ¨Ūē®ŽźúŽč§.

Ūö®žö©Ūē®žąė :Ž™©ž†Ā Ūē®žąė: žĶúž†ĀŪôĒžóźžĄú žā¨žö©ŽźėŽäĒ žĚľŽįėž†ĀžĚł žö©žĖī.žÜźžč§ Ūē®žąė :Ž≥īžÉĀ Ūē®žąė: ÍįēŪôĒ ŪēôžäĶ žóźžĄú žā¨žö©ŽźúŽč§.ž†ĀŪē©ŽŹĄ Ūē®žąė: žßĄŪôĒ žčúžä§ŪÖú žóźžĄú žā¨žö©ŽźúŽč§.Ž™©ŪĎú, Í∑łŽ¶¨Í≥† ŽĒįŽĚľžĄú Ž™©ž†Ā Ūē®žąėŽäĒ Žč§žĚĆÍ≥ľ ÍįôžĚĄ žąė žěąŽč§.

Ž™Öžčúž†ĀžúľŽ°ú ž†ēžĚėŽź®: žóźžĚīž†ĄŪäłžóź žßĀž†Ď ŪĒĄŽ°úÍ∑łŽěėŽį掟®.žú†ŽŹĄŽź®: žčúÍįĄžĚī žßÄŽā®žóź ŽĒįŽĚľ ŪēôžäĶŽźėÍĪįŽāė žßĄŪôĒŽź®.

ÍįēŪôĒ ŪēôžäĶ žßĄŪôĒ žčúžä§ŪÖú žĶúÍ∑ľž†Ď žĚīžõÉ Í≥ľ ÍįôžĚī ž†ĄŪÜĶž†ĀžúľŽ°ú žóźžĚīž†ĄŪ䳎°ú ÍįĄž£ľŽźėžßÄ žēäŽäĒ žĚľŽ∂Ä AI žčúžä§ŪÖúžĚÄ Ž™Öžčúž†ĀžúľŽ°ú Ž™©ŪĎú žßÄŪĖ•ž†ĀžĚīžßÄ žēäÍ≥† žú†ž∂ĒŽ•ľ ŪÜĶŪēī ž∂ĒŽ°†ŪēúŽč§. Í∑łŽü¨Žāė žĚīŽü¨Ūēú žčúžä§ŪÖúž°įžį®ŽŹĄ ŪēôžäĶ ŽćįžĚīŪĄį Žāīžóź žēĒŽ¨Ķž†ĀžúľŽ°ú ž†ēžĚėŽźú Ž™©ŪĎúŽ•ľ ÍįÄžßą žąė žěąŽč§. žĚīŽü¨Ūēú žčúžä§ŪÖúžĚÄ ŽĻĄŽ™©ŪĎú žčúžä§ŪÖúžĚĄ ŪėĎžÜĆŪēú Ž∂ĄŽ•ė žěĎžó̥֞ žąėŪĖČŪēėŽäĒ "Ž™©ŪĎú"Ž•ľ ÍįĞߥ žčúžä§ŪÖúžúľŽ°ú ÍĶ¨žĄĪŪē®žúľŽ°úžć® žó¨ž†ĄŪěą Ž≤§žĻėŽßąŪāĻ Ūē† žąė žěąŽč§.[ 8]

žßÄžčĚ ŪĎúŪėĄ žčúžä§ŪÖú Í≥ľ ÍįôžĚī ž†ĄŪÜĶž†ĀžúľŽ°ú žóźžĚīž†ĄŪ䳎°ú ÍįĄž£ľŽźėžßÄ žēäŽäĒ žčúžä§ŪÖúŽŹĄ žßąŽ¨łžóź ž†ēŪôēŪēėÍ≤Ć ŽčĶŪēėŽäĒ Í≤ɞ̥ Ž™©ŪĎúŽ°ú ŪēėŽäĒ žóźžĚīž†ĄŪ䳎°ú ÍĶ¨žĄĪŪē®žúľŽ°úžć® ŽēĆŽēĆŽ°ú ŪĆ®Žü¨Žč§žěĄ žóź ŪŹ¨Ūē®ŽźúŽč§. žó¨ÍłįžĄúŽäĒ "ŪĖČŽŹô"žĚė ÍįúŽÖźžĚī ŽčĶŽ≥Ğ̥ ž†úÍ≥ĶŪēėŽäĒ "ŪĖČžúĄ"Ž•ľ ŪŹ¨Ūē®ŪēėŽŹĄŽ°Ě Ūôēžě•ŽźúŽč§. ŽćĒ ŽāėžēĄÍįÄ, Ž™®Žį© ÍłįŽįė žčúžä§ŪÖúžĚÄ IAÍįÄ žõźŪēėŽäĒ ŪĖČŽŹôžĚĄ žĖľŽßąŽāė ÍįÄÍĻĚÍ≤Ć Ž™®Žį©ŪēėŽäĒžßÄžóź ŽĒįŽĚľ "Ž™©ŪĎú Ūē®žąė"Ž•ľ žĶúž†ĀŪôĒŪēėŽäĒ žóźžĚīž†ĄŪ䳎°ú ÍĶ¨žĄĪŽź† žąė žěąŽč§.[ 3] žÉĚžĄĪž†Ā ž†ĀŽĆÄ žč†Í≤ĹŽßĚ (GAN)žóźžĄú "žĚłžĹĒŽćĒ"/"žÉĚžĄĪÍłį" ÍĶ¨žĄĪ žöĒžÜĆŽäĒ žĚłÍįĄžĚė ŪÖćžä§Ūäł ÍĶ¨žĄĪ Žį©žč̞̥ Ž™®Žį©ŪēėÍ≥† ž¶ČŪĚ•ž†ĀžúľŽ°ú žčúŽŹĄŪēúŽč§. žÉĚžĄĪÍłįŽäĒ ž†ĀŽĆÄž†ĀžĚł "žėąžł°Íłį"/"ŪĆźŽ≥ĄÍłį" ÍĶ¨žĄĪ žöĒžÜĆŽ•ľ žĖľŽßąŽāė žěė žÜćžĚľ žąė žěąŽäĒžßÄŽ•ľ ŽāėŪÉÄŽāīŽäĒ Ūē®žąėŽ•ľ žĶúŽĆÄŪôĒŪēėŽ†§Í≥† žčúŽŹĄŪēúŽč§.[ 9]

ÍłįŪėł AI žčúžä§ŪÖúžĚÄ žĘÖžĘÖ Ž™Öžčúž†ĀžĚł Ž™©ŪĎú Ūē®žąėŽ•ľ žā¨žö©ŪēėžßÄŽßĆ, žĚī ŪĆ®Žü¨Žč§žěĄžĚÄ žĚłÍ≥Ķ žč†Í≤ĹŽßĚ ŽįŹ žßĄŪôĒ Í≥Ąžāį žóźŽŹĄ ž†Āžö©ŽźúŽč§. ÍįēŪôĒ ŪēôžäĶ žĚÄ "Ž≥īžÉĀ Ūē®žąė"Ž•ľ žĶúŽĆÄŪôĒŪēėŽ†§ŽäĒ Žį©žčĚžúľŽ°ú ŪĖČŽŹôŪēėŽäĒ Í≤Éž≤ėŽüľ Ž≥īžĚīŽäĒ žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎•ľ žÉĚžĄĪŪē† žąė žěąŽč§.[ 10] [ 11] žĖÄ Ž•īžŅ§ žĚÄ 2018ŽÖĄžóź "žā¨ŽěƎ吏Ěī Í≥†žēąŪēīŽāł ŽĆÄŽ∂ÄŽ∂ĄžĚė ŪēôžäĶ žēĆÍ≥†Ž¶¨ž¶ėžĚÄ Ž≥łžßąž†ĀžúľŽ°ú žĖīŽĖ§ Ž™©ž†Ā Ūē®žąėŽ•ľ žĶúžÜĆŪôĒŪēėŽäĒ Í≤ÉžúľŽ°ú ÍĶ¨žĄĪŽźėžĖī žěąŽč§"Í≥† ŽßźŪĖąŽč§.[ 12] žēĆŪĆĆž†úŽ°ú ž≤īžä§ŽäĒ žäĻŽ¶¨ žčú +1ž†ź, ŪĆ®Žįį žčú -1ž†źžĚīŽĚľŽäĒ Žč®žąúŪēú Ž™©ž†Ā Ūē®žąėŽ•ľ ÍįÄžßÄÍ≥† žěąžóąŽč§. žěźžú® ž£ľŪĖČ žį®ŽüČžĚė Ž™©ž†Ā Ūē®žąėŽäĒ ŽćĒ Ž≥Ķžě°Ūē† Í≤ÉžĚīŽč§.[ 13] [ 5]

AIXI žĚė žąėŪēôž†Ā ŪėēžčĚž£ľžĚėŽäĒ žĚī ŪĆ®Žü¨Žč§žěĄžóźžĄú žĶúŽĆÄ žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎°ú ž†úžēąŽźėžóąŽč§.[ 14] Í≥Ąžāį Ž∂ąÍįÄŽä• . ŪėĄžč§ žĄłÍ≥ĄžóźžĄú IAŽäĒ žú†ŪēúŪēú žčúÍįĄÍ≥ľ ŪēėŽďúžõ®žĖī žěźžõźžóź ž†úžēŞ̥ ŽįõžúľŽ©į, Í≥ľŪēôžěźŽď§žĚÄ Íłįž°ī ŪēėŽďúžõ®žĖīŽ°ú Ž≤§žĻėŽßąŪĀ¨ ŪÖĆžä§Ū䳞󟞥ú ž†źžßĄž†ĀžúľŽ°ú ŽćĒ ŽÜížĚÄ ž†źžąėŽ•ľ Žč¨žĄĪŪēėŽäĒ žēĆÍ≥†Ž¶¨ž¶ėžĚĄ žÉĚžāįŪēėÍłį žúĄŪēī Í≤ĹžüĀŪēúŽč§.[ 15]

žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė ŪĖČŽŹôžĚÄ žóźžĚīž†ĄŪäł Ūē®žąė Ž°ú žąėŪēôž†ĀžúľŽ°ú žĄ§Ž™ÖŽź† žąė žěąŽč§. žĚī Ūē®žąėŽäĒ žóźžĚīž†ĄŪäłÍįÄ Ž≥ł Í≤ɞ̥ ÍłįŽįėžúľŽ°ú Ž¨īžóážĚĄ Ūē†žßÄ Í≤įž†ēŪēúŽč§.

žĚłžčĚ žĚÄ ŪäĻž†ē žčúž†źžóźžĄú žóźžĚīž†ĄŪäłžĚė ÍįźÍįĀ žěÖŽ†•Ž•ľ ŽßźŪēúŽč§. žėąŽ•ľ Žď§žĖī, žěźžú® ž£ľŪĖČ žį®ŽüČžĚė žĚłžčĚžóźŽäĒ ŪäĻž†ē žąúÍįĄžĚė žĻīŽ©ĒŽĚľ žĚīŽĮłžßÄ, ŽĚľžĚīŽč§ ŽćįžĚīŪĄį, GPS žĘĆŪĎú ŽįŹ žÜ掏Ą ŪĆźŽŹÖÍįížĚī ŪŹ¨Ūē®Žź† žąė žěąŽč§. žóźžĚīž†ĄŪ䳎äĒ žĚīŽü¨Ūēú žĚłžčĚÍ≥ľ žě†žě¨ž†ĀžúľŽ°ú žĚłžčĚžĚė žĚīŽ†•žĚĄ žā¨žö©Ūēėžó¨ Žč§žĚĆ ŪĖČŽŹô(žėą: ÍįÄžÜć, ž†úŽŹô, ŪöĆž†Ą)žĚĄ Í≤įž†ēŪēúŽč§.

žóźžĚīž†ĄŪäł Ūē®žąėŽäĒ žĘÖžĘÖ fŽ°ú ŪĎúžčúŽźėŽ©į, žóźžĚīž†ĄŪäłžĚė ž†Ąž≤ī žĚłžčĚ žĚīŽ†•žĚĄ ŪĖČŽŹôžóź Žß§ŪēĎŪēúŽč§.[ 16]

žąėŪēôž†ĀžúľŽ°úŽäĒ Žč§žĚĆÍ≥ľ ÍįôžĚī ŪĎúŪėĄŪē† žąė žěąŽč§.

f

:

P

‚ąó

‚Üí

A

{\displaystyle f:P^{*}\rightarrow A}

žó¨ÍłįžĄú:

P\ * ŽäĒ ÍįÄŽä•Ūēú Ž™®Žď† žĚłžčĚ žčúŪÄĞ䧞Ěė žßĎŪē©(žóźžĚīž†ĄŪäłžĚė ž†Ąž≤ī žĚłžčĚ žĚīŽ†•)žĚĄ ŽāėŪÉÄŽāłŽč§. Ž≥ĄŪĎú(*)ŽäĒ 0Íįú žĚīžÉĀžĚė žĚłžčĚ žčúŪÄĞ䧎•ľ ŽāėŪÉÄŽāłŽč§.A ŽäĒ žóźžĚīž†ĄŪäłÍįÄ ž∑®Ūē† žąė žěąŽäĒ ÍįÄŽä•Ūēú Ž™®Žď† ŪĖČŽŹôžĚė žßĎŪē©žĚĄ ŽāėŪÉÄŽāłŽč§.f ŽäĒ žĚłžčĚ žčúŪÄĞ䧎•ľ ŪĖČŽŹôžóź Žß§ŪēĎŪēėŽäĒ žóźžĚīž†ĄŪäł Ūē®žąėžĚīŽč§.žóźžĚīž†ĄŪäł Ūē®žąė(ž∂ĒžÉĀž†ĀžĚł žąėŪēôž†Ā ÍįúŽÖź)žôÄ žóźžĚīž†ĄŪäł ŪĒĄŽ°úÍ∑łŽě®(Í∑ł Ūē®žąėžĚė ÍĶ¨ž≤īž†ĀžĚł ÍĶ¨ŪėĄ)žĚĄ ÍĶ¨Ž≥ĄŪēėŽäĒ Í≤ÉžĚī ž§ĎžöĒŪēėŽč§.

žóźžĚīž†ĄŪäł Ūē®žąėŽäĒ žĚīŽ°†ž†ĀžĚł žĄ§Ž™ÖžĚīŽč§.

žóźžĚīž†ĄŪäł ŪĒĄŽ°úÍ∑łŽě®žĚÄ žóźžĚīž†ĄŪ䳞󟞥ú žč§ŪĖČŽźėŽäĒ žč§ž†ú žĹĒŽďúžĚīŽč§. žóźžĚīž†ĄŪäł ŪĒĄŽ°úÍ∑łŽě®žĚÄ ŪėĄžě¨ žĚłžč̞̥ žěÖŽ†•žúľŽ°ú ŽįõžēĄ ŪĖČŽŹôžĚĄ ž∂úŽ†•žúľŽ°ú žÉĚžĄĪŪēúŽč§. žóźžĚīž†ĄŪäł Ūē®žąėŽäĒ Žč§žĚƞ̥ ŪŹ¨Ūē®Ūēú Žč§žĖĎŪēú žĚėžā¨Í≤įž†ē ž†ĎÍ∑ľ Žį©žč̞̥ ŪÜĶŪē©Ūē† žąė žěąŽč§.[ 17]

Žč§žĖĎŪēú ŪĖČŽŹôžĚė žú†žö©žĄĪ(ŽįĒŽěĆžßĀŪē®) Í≥Ąžāį.

ŽÖľŽ¶¨ Í∑úžĻô ŽįŹ žóįžó≠ žā¨žö©.

ŪćľžßÄ ŽÖľŽ¶¨ žā¨žö©.

ÍłįŪÉÄ Žį©Ž≤ē.

Russell & Norvig (2003) ŽäĒ žóźžĚīž†ĄŪ䳎•ľ žĚłžßÄŽźú žßÄŽä• ŽįŹ Žä•Ž†• ž†ēŽŹĄžóź ŽĒįŽĚľ Žč§žĄĮ ÍįÄžßÄ ŪĀīŽěėžä§Ž°ú Ž∂ĄŽ•ėŪēúŽč§.[ 18]

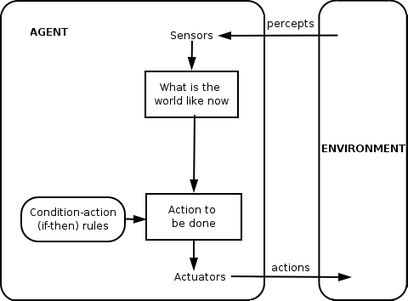

Žč®žąú Žįėžā¨ žóźžĚīž†ĄŪäł Žč®žąú Žįėžā¨ žóźžĚīž†ĄŪ䳎äĒ ŪėĄžě¨ žßÄÍįĀ žóźŽßĆ Í∑ľÍĪįŪēėžó¨ ŪĖČŽŹôŪēėŽ©į, ŽāėŽ®łžßÄ žßÄÍįĀ žĚīŽ†•žĚĄ Ž¨īžčúŪēúŽč§. žóźžĚīž†ĄŪäł Ūē®žąėŽäĒ ž°įÍĪī-ŪĖČŽŹô Í∑úžĻô, ž¶Č "ŽßĆžēĹ ž°įÍĪīžĚīŽ©ī, ŪĖČŽŹô"žóź ÍłįŽįėŪēúŽč§.

žĚī žóźžĚīž†ĄŪäł Ūē®žąėŽäĒ ŪôėÍ≤ĹžĚī žôĄž†ĄŪěą ÍīÄžįį ÍįÄŽä•Ūē† ŽēĆŽßĆ žĄĪÍ≥ĶŪēúŽč§. žĚľŽ∂Ä Žįėžā¨ žóźžĚīž†ĄŪ䳎äĒ ŪėĄžě¨ žÉĀŪÉúžóź ŽĆÄŪēú ž†ēŽ≥īŽ•ľ ŪŹ¨Ūē®Ūē† žąėŽŹĄ žěąžúľŽ©į, žĚīŽ•ľ ŪÜĶŪēī žē°ž∂ĒžóźžĚīŪĄįÍįÄ žĚīŽĮł žěĎŽŹô ž§ĎžĚł ž°įÍĪīžĚĄ Ž¨īžčúŪē† žąė žěąŽč§.

Žč®žąú Žįėžā¨ žóźžĚīž†ĄŪäłÍįÄ Ž∂ÄŽ∂Ąž†ĀžúľŽ°ú ÍīÄžįį ÍįÄŽä•Ūēú ŪôėÍ≤Ş󟞥ú žěĎŽŹôŪēėŽäĒ Í≤Ĺžöį Ž¨īŪēú Ž£®ŪĒĄ ŽäĒ žĘÖžĘÖ ŪĒľŪē† žąė žóÜŽč§. žóźžĚīž†ĄŪäłÍįÄ ŪĖČŽŹôžĚĄ Ž¨īžěĎžúĄŪôĒŪē† žąė žěąŽč§Ž©ī Ž¨īŪēú Ž£®ŪĒĄžóźžĄú Ž≤óžĖīŽā† žąė žěąŽč§.

žė®ŽŹĄÍįÄ ŪäĻž†ē žßÄž†ź žĚīŪēėŽ°ú ŽĖ®žĖīžßÄŽ©ī žľúžßÄÍĪįŽāė ÍļľžßÄŽäĒ ÍįÄž†ēžö© žė®ŽŹĄž°įž†ąÍłį ŽäĒ Žč®žąú Žįėžā¨ žóźžĚīž†ĄŪäłžĚė Ūēú žėąžĚīŽč§.[ 19] [ 20]

Ž™®Žćł ÍłįŽįė Žįėžā¨ žóźžĚīž†ĄŪäł Ž™®Žćł ÍłįŽįė žóźžĚīž†ĄŪ䳎äĒ Ž∂ÄŽ∂Ąž†ĀžúľŽ°ú ÍīÄžįį ÍįÄŽä•Ūēú ŪôėÍ≤Ş̥ ž≤ėŽ¶¨Ūē† žąė žěąŽč§. ŪėĄžě¨ žÉĀŪÉúŽäĒ žóźžĚīž†ĄŪäł ŽāīŽ∂Äžóź ž†Äžě•ŽźėžĖī žěąžúľŽ©į, Ž≥īžĚīžßÄ žēäŽäĒ žĄłÍ≥ĄžĚė žĚľŽ∂ÄŽ•ľ žĄ§Ž™ÖŪēėŽäĒ ÍĶ¨ž°įŽ•ľ žú†žßÄŪēúŽč§. "žĄłÍ≥ĄÍįÄ žĖīŽĖĽÍ≤Ć žěĎŽŹôŪēėŽäĒžßÄ"žóź ŽĆÄŪēú žĚīŽü¨Ūēú žßÄžč̞̥ žĄłÍ≥ĄžĚė Ž™®ŽćłžĚīŽĚľÍ≥† Ž∂ÄŽ•īŽ©į, ŽĒįŽĚľžĄú "Ž™®Žćł ÍłįŽįė žóźžĚīž†ĄŪäł"ŽĚľŽäĒ žĚīŽ¶ĄžĚī Ž∂ôžóąŽč§.

Ž™®Žćł ÍłįŽįė Žįėžā¨ žóźžĚīž†ĄŪ䳎äĒ žßÄÍįĀ žĚīŽ†•žóź žĚėž°īŪēėŽ©į ŪėĄžě¨ žÉĀŪÉúžĚė ÍīÄžįįŽźėžßÄ žēäžĚÄ žł°Ž©ī ž§Ď žĚľŽ∂ÄŽĚľŽŹĄ ŽįėžėĀŪēėŽäĒ žĚľžĘÖžĚė ŽāīŽ∂Ä Ž™®Žćł žĚĄ žú†žßÄŪēīžēľ ŪēúŽč§. žßÄÍįĀ žĚīŽ†•Í≥ľ ŪôėÍ≤Ĺžóź ŽĆÄŪēú ŪĖČŽŹôžĚė žėĀŪĖ•žĚÄ ŽāīŽ∂Ä Ž™®ŽćłžĚĄ žā¨žö©Ūēėžó¨ Í≤įž†ēŪē† žąė žěąŽč§. Í∑łŽüį Žč§žĚĆ Žįėžā¨ žóźžĚīž†ĄŪäłžôÄ ŽŹôžĚľŪēú Žį©žčĚžúľŽ°ú ŪĖČŽŹôžĚĄ žĄ†ŪÉĚŪēúŽč§.

žóźžĚīž†ĄŪ䳎äĒ ŪôėÍ≤Ĺ ŽāīžĚė Žč§Ž•ł žóźžĚīž†ĄŪäłžĚė ŪĖČŽŹôžĚĄ žĄ§Ž™ÖŪēėÍ≥† žėąžł°ŪēėŽäĒ Žćį Ž™®ŽćłžĚĄ žā¨žö©Ūē† žąėŽŹĄ žěąŽč§.[ 21]

Ž™®Žćł ÍłįŽįė, Ž™©ŪĎú ÍłįŽįė žóźžĚīž†ĄŪäł Ž™©ŪĎú ÍłįŽįė žóźžĚīž†ĄŪ䳎äĒ "Ž™©ŪĎú" ž†ēŽ≥īŽ•ľ žā¨žö©Ūēėžó¨ Ž™®Žćł ÍłįŽįė žóźžĚīž†ĄŪäłžĚė ÍłįŽä•žĚĄ ŽćĒžöĪ Ūôēžě•ŪēúŽč§. Ž™©ŪĎú ž†ēŽ≥īŽäĒ ŽįĒŽěĆžßĀŪēú žÉĀŪô©žĚĄ žĄ§Ž™ÖŪēúŽč§. žĚīŽäĒ žóźžĚīž†ĄŪäłÍįÄ žó¨Žü¨ ÍįÄŽä•žĄĪ ž§ĎžóźžĄú Ž™©ŪĎú žÉĀŪÉúžóź ŽŹĄŽč¨ŪēėŽäĒ Í≤ɞ̥ žĄ†ŪÉĚŪēėŽäĒ Žį©Ž≤ēžĚĄ ž†úÍ≥ĶŪēúŽč§. ŪÉźžÉČ ŽįŹ Í≥ĄŪöć žĚÄ žóźžĚīž†ĄŪäłžĚė Ž™©ŪĎúŽ•ľ Žč¨žĄĪŪēėŽäĒ ŪĖČŽŹô žčúŪÄĞ䧎•ľ žįĺŽäĒ Žćį ž†ĄŽÖźŪēėŽäĒ žĚłÍ≥ĶžßÄŽä•žĚė ŪēėžúĄ Ž∂ĄžēľžĚīŽč§.

žĪóGPT žôÄ Ž£łŽįĒ žßĄÍ≥Ķž≤≠žÜĆÍłįŽäĒ Ž™©ŪĎú ÍłįŽįė žóźžĚīž†ĄŪäłžĚė žėąžĚīŽč§.[ 22]

Ž™®Žćł ÍłįŽįė, Ūö®žö© ÍłįŽįė žóźžĚīž†ĄŪäł Ž™©ŪĎú ÍłįŽįė žóźžĚīž†ĄŪ䳎äĒ Ž™©ŪĎú žÉĀŪÉúžôÄ ŽĻĄŽ™©ŪĎú žÉĀŪÉúŽßƞ̥ ÍĶ¨Ž≥ĄŪēúŽč§. ŪäĻž†ē žÉĀŪÉúÍįÄ žĖľŽßąŽāė ŽįĒŽěĆžßĀŪēúžßÄžóź ŽĆÄŪēú ž≤ôŽŹĄŽ•ľ ž†ēžĚėŪēėŽäĒ Í≤ÉŽŹĄ ÍįÄŽä•ŪēėŽč§. žĚī ž≤ôŽŹĄŽäĒ žÉĀŪÉúžĚė Ūö®žö©žĚĄ žł°ž†ēŪēėŽäĒ Ūö®žö© Ūē®žąėŽ•ľ žā¨žö©Ūēėžó¨ žĖĽžĚĄ žąė žěąŽč§. ŽćĒ žĚľŽįėž†ĀžĚł žĄĪŽä• žł°ž†ēžĚÄ žóźžĚīž†ĄŪäłžĚė Ž™©ŪĎúŽ•ľ žĖľŽßąŽāė žěė ž∂©ž°ĪŪĖąŽäĒžßÄžóź ŽĒįŽĚľ Žč§Ž•ł žĄłÍ≥Ą žÉĀŪÉúŽ•ľ ŽĻĄÍĶź Ūē† žąė žěąŽŹĄŽ°Ě Ūēīžēľ ŪēúŽč§. Ūö®žö©žĚīŽĚľŽäĒ žö©žĖīŽäĒ žóźžĚīž†ĄŪäłÍįÄ žĖľŽßąŽāė "ŪĖČŽ≥ĶŪēúžßÄ"Ž•ľ žĄ§Ž™ÖŪēėŽäĒ Žćį žā¨žö©Žź† žąė žěąŽč§.

Ūē©Ž¶¨ž†ĀžĚł Ūö®žö© ÍłįŽįė žóźžĚīž†ĄŪ䳎äĒ ŪĖČŽŹô Í≤įÍ≥ľžĚė ÍłįŽĆÄ Ūö®žö©žĚĄ žĶúŽĆÄŪôĒŪēėŽäĒ ŪĖČŽŹôžĚĄ žĄ†ŪÉĚŪēúŽč§. ž¶Č, ÍįĀ Í≤įÍ≥ľžĚė ŪôēŽ•†Í≥ľ Ūö®žö©žĚĄ Í≥†Ž†§Ūē† ŽēĆ žóźžĚīž†ĄŪäłÍįÄ ŪŹČÍ∑†ž†ĀžúľŽ°ú žĖĽžĚĄ Í≤ÉžúľŽ°ú žėąžÉĀŪēėŽäĒ Í≤ɞ̥ žĄ†ŪÉĚŪēúŽč§. Ūö®žö© ÍłįŽįė žóźžĚīž†ĄŪ䳎äĒ ŪôėÍ≤Ş̥ Ž™®ŽćłŽßĀŪēėÍ≥† ž∂Ēž†ĀŪēīžēľ ŪēėŽ©į, žĚīŽü¨Ūēú žěĎžóÖžĚÄ žßÄÍįĀ, ŪĎúŪėĄ, ž∂ĒŽ°† ŽįŹ ŪēôžäĶžóź ŽĆÄŪēú ŽßéžĚÄ žóįÍĶ¨Ž•ľ žąėŽįėŪĖąŽč§.

žĚľŽįėž†ĀžĚł ŪēôžäĶ žóźžĚīž†ĄŪäł ŪēôžäĶžĚĄ ŪÜĶŪēī žóźžĚīž†ĄŪ䳎äĒ žēĆ žąė žóÜŽäĒ ŪôėÍ≤Ş󟞥ú žčúžěĎŪēėžó¨ ž†źžį® žīąÍłį žßÄžčĚžĚė ŪēúÍ≥ĄŽ•ľ ŽĄėžĖīžĄ§ žąė žěąŽč§. žĚīŽü¨Ūēú žóźžĚīž†ĄŪäłžĚė ŪēĶžč¨ž†ĀžĚł ÍĶ¨Ž∂ĄžĚÄ žĄĪŽä• ŪĖ•žÉĀžĚĄ ŽčīŽčĻŪēėŽäĒ "ŪēôžäĶ žöĒžÜĆ"žôÄ žôłŽ∂Ä ŪĖČŽŹô žĄ†ŪÉ̞̥ ŽčīŽčĻŪēėŽäĒ "žĄĪŽä• žöĒžÜĆ"žĚė Ž∂ĄŽ¶¨žĚīŽč§.

ŪēôžäĶ žöĒžÜĆŽäĒ "ŪŹČŽ°†ÍįÄ"Ž°úŽ∂ÄŪĄį ŪĒľŽďúŽįĪžĚĄ žąėžßĎŪēėžó¨ žóźžĚīž†ĄŪäłžĚė žĄĪŽä•žĚĄ ŪŹČÍįÄŪēėÍ≥†, "ŪĖČžúĄžěź"ŽĚľÍ≥†ŽŹĄ Ž∂ąŽ¶¨ŽäĒ žĄĪŽä• žöĒžÜĆŽ•ľ žĖīŽĖĽÍ≤Ć ž°įž†ēŪēėžó¨ ŽćĒ ŽāėžĚÄ Í≤įÍ≥ľŽ•ľ žāįž∂úŪē† žąė žěąŽäĒžßÄ Í≤įž†ēŪēúŽč§. žĚīž†ĄžóźŽäĒ ž†Ąž≤ī žóźžĚīž†ĄŪ䳎°ú ÍįĄž£ľŽźėžóąŽćė žĄĪŽä• žöĒžÜĆŽäĒ žĚłžč̞̥ ŪēīžĄĚŪēėÍ≥† ŪĖČŽŹôžĚĄ ž∑®ŪēúŽč§.

žĶúžĘÖ ÍĶ¨žĄĪ žöĒžÜƞ̳ "Ž¨łž†ú žÉĚžĄĪÍłį"ŽäĒ ŪÉźžÉČÍ≥ľ ž∂ĒÍįÄ ÍįúžĄ†žĚĄ žě•Ž†§ŪēėŽäĒ žÉąŽ°≠Í≥† žú†žĚĶŪēú Í≤ĹŪóėžĚĄ ž†úžēąŪēúŽč§.

Weiss (2013) žóź ŽĒįŽ•īŽ©ī, žóźžĚīž†ĄŪ䳎äĒ ŽĄ§ ÍįÄžßÄ ŪĀīŽěėžä§Ž°ú Ž∂ĄŽ•ėŽź† žąė žěąŽč§.

ŽÖľŽ¶¨ ÍłįŽįė žóźžĚīž†ĄŪäł: ŪĖČŽŹôžóź ŽĆÄŪēú Í≤įž†ēžĚī ŽÖľŽ¶¨ž†Ā žóįžó≠ žĚĄ ŪÜĶŪēī ŽŹĄž∂úŽźėŽäĒ žóźžĚīž†ĄŪäł.

ŽįėžĚĎŪėē žóźžĚīž†ĄŪäł: žÉĀŪô©žóźžĄú ŪĖČŽŹôžúľŽ°ú žßĀž†Ď Žß§ŪēϞ̥ ŪÜĶŪēī Í≤įž†ēžĚī žĚīŽ£®žĖīžßÄŽäĒ žóźžĚīž†ĄŪäł.

žč†ŽÖź-žöēÍĶ¨-žĚėŽŹĄ žóźžĚīž†ĄŪäł: žóźžĚīž†ĄŪäłžĚė žč†ŽÖź, žöēÍĶ¨, žĚėŽŹĄŽ•ľ ŽāėŪÉÄŽāīŽäĒ žěźŽ£Ć ÍĶ¨ž°į Ž•ľ ž°įžěĎŪēėŽäĒ Í≤Éžóź ŽĒįŽĚľ Í≤įž†ēžĚī Žč¨ŽĚľžßÄŽäĒ žóźžĚīž†ĄŪäł.

Í≥ĄžłĶŪėē žēĄŪā§ŪÖćž≤ė: žĚėžā¨Í≤įž†ēžĚī žó¨Žü¨ žÜĆŪĒĄŪäłžõ®žĖī Í≥ĄžłĶžóź ÍĪłž≥ź žĚīŽ£®žĖīžßÄŽ©į, ÍįĀ Í≥ĄžłĶžĚÄ Žč§Ž•ł ž∂ĒžÉĀŪôĒ žąėž§ÄžóźžĄú ŪôėÍ≤Ĺžóź ŽĆÄŪēī ž∂ĒŽ°†ŪēúŽč§.

2013ŽÖĄ žēĆŽ†ČžāįŽćĒ žúĄžä§ŽĄą-Í∑łŽ°úžä§ŽäĒ žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė žßÄŽä• Í≥ľ žěźžú† žā¨žĚīžĚė ÍīÄÍ≥ĄŽ•ľ ŪÉźÍĶ¨ŪēėŽäĒ žĚīŽ°†žĚĄ ŽįúŪĎúŪĖąŽč§.[ 23] [ 24]

žßÄŽä•Ūėē žóźžĚīž†ĄŪ䳎äĒ žó¨Žü¨ "ŪēėžúĄ žóźžĚīž†ĄŪäł"Ž°ú Í≥ĄžłĶž†ĀžúľŽ°ú ÍĶ¨žĄĪŽź† žąė žěąŽč§. žĚī ŪēėžúĄ žóźžĚīž†ĄŪ䳎吏ĚÄ ŪēėžúĄ žąėž§Ä ÍłįŽä•žĚĄ ž≤ėŽ¶¨ŪēėŽ©į, ž£ľ žóźžĚīž†ĄŪäłžôÄ Ūē®ÍĽė Ž≥Ķžě°Ūēú žěĎžó̥֞ žč§ŪĖČŪēėÍ≥† žĖīŽ†§žöī Ž™©ŪĎúŽ•ľ Žč¨žĄĪŪē† žąė žěąŽäĒ žôĄž†ĄŪēú žčúžä§ŪÖúžĚĄ ŪėēžĄĪŪēúŽč§.

žĚľŽįėž†ĀžúľŽ°ú žóźžĚīž†ĄŪ䳎äĒ žĄľžĄúžôÄ žē°ž∂ĒžóźžĚīŪĄįŽ°ú ŽāėŽČėžĖī ÍĶ¨žĄĪŽźúŽč§. žßÄÍįĀ žčúžä§ŪÖúžĚÄ žĄľžĄúŽ•ľ ŪÜĶŪēī ŪôėÍ≤ĹžúľŽ°úŽ∂ÄŪĄį žěÖŽ†•žĚĄ žąėžßĎŪēėžó¨ žĚī ž†ēŽ≥īŽ•ľ ž§Ďžēô ž†úžĖīÍłįŽ°ú ž†ĄŽč¨ŪēėÍ≥†, ž§Ďžēô ž†úžĖīÍłįŽäĒ žē°ž∂ĒžóźžĚīŪĄįžóź Ž™ÖŽ†ĻžĚĄ ŽāīŽ¶įŽč§. žĘÖžĘÖ ŪēėžúĄ žąėž§Ä žěĎžóÖžóź ŪēĄžöĒŪēú ŽĻ†Ž•ł žĚĎŽčĶÍ≥ľ žÉĀžúĄ žąėž§Ä Ž™©ŪĎúžóź ŪēĄžöĒŪēú ŽćĒ žč¨žā¨žąôÍ≥†Ūēú ž∂ĒŽ°†žĚė Í∑†ŪėēžĚĄ Žßěž∂ĒÍłį žúĄŪēī Žč§žłĶ ž†úžĖīÍłį Í≥ĄžłĶžĚī ŪēĄžöĒŪēėŽč§.[ 25]

"žßÄŽä•Ūėē žóźžĚīž†ĄŪäł"ŽäĒ žĘÖžĘÖ "ÍįÄžÉĀ ÍįúžĚł ŽĻĄžĄú "žôÄ ŽŹôžĚėžĖīŽ°ú Ž™®ŪėłŪēėÍ≤Ć žā¨žö©ŽźėÍłįŽŹĄ ŪēúŽč§.[ 26] [ 27] žÜĆŪĒĄŪäłžõ®žĖī žóźžĚīž†ĄŪäł Ž°ú žēĆŽ†§ž†ł žěąžúľŽ©į, ŽēĆŽ°úŽäĒ "žßÄŽä•Ūėē žÜĆŪĒĄŪäłžõ®žĖī žóźžĚīž†ĄŪäł"(ž¶Č, žßĎ䕞̥ ÍįĞߥ žÜĆŪĒĄŪäłžõ®žĖī žóźžĚīž†ĄŪäł)Ž•ľ "žßÄŽä•Ūėē žóźžĚīž†ĄŪäł"ŽĚľÍ≥† Ž∂ÄŽ•īÍłįŽŹĄ ŪēúŽč§.

ŽčąžĹúŽĚľ žĻīžā¨Ž≥īŪĒĄ ŽäĒ 1998ŽÖĄžóź IA žčúžä§ŪÖúžĚī Žč§žĚĆ ŪäĻžĄĪžĚĄ Ž≥īžó¨žēľ ŪēúŽč§Í≥† ŽßźŪĖąŽč§.

žÉąŽ°úžöī Ž¨łž†ú ŪēīÍ≤į Í∑úžĻôžĚĄ ž†źžßĄž†ĀžúľŽ°ú žąėžö©ŪēúŽč§.

žė®ŽĚľžĚł ŽįŹ žč§žčúÍįĄ žúľŽ°ú ž†ĀžĚĎŪēúŽč§.žěźžč† žĚĄ ŪĖČŽŹô, žė§Ž•ė, žĄĪÍ≥Ķ žł°Ž©īžóźžĄú Ž∂ĄžĄĚŪē† žąė žěąŽč§.ŪôėÍ≤ĹÍ≥ľžĚė žÉĀŪėłžěĎžö©žĚĄ ŪÜĶŪēī ŪēôžäĶŪēėÍ≥† ÍįúžĄ†ŪēúŽč§ (ÍĶ¨ŪėĄ ).

ŽßéžĚÄ žĖĎžĚė ŽćįžĚīŪĄį Ž°úŽ∂ÄŪĄį ŽĻ†Ž•īÍ≤Ć ŪēôžäĶŪēúŽč§.

Ž©ĒŽ™®Ž¶¨ ÍłįŽįė žėąž†ú ž†Äžě• ŽįŹ Í≤ÄžÉČ ÍłįŽä•žĚĄ ÍįĖŽäĒŽč§.

Žč®Íłį ŽįŹ žě•Íłį Ž©ĒŽ™®Ž¶¨, žóįŽ†Ļ, ŽßĚÍįĀ ŽďĪžĚĄ ŽāėŪÉÄŽāīŽäĒ Žß§ÍįúŽ≥Äžąė Ž•ľ ÍįĖŽäĒŽč§.

žÉĚžĄĪŪėē žĚłÍ≥ĶžßÄŽä• žĚė Žß•ŽĚŞ󟞥ú AI žóźžĚīž†ĄŪäł (Ž≥ĶŪē© AI žčúžä§ŪÖú žĚīŽĚľÍ≥†ŽŹĄ Ūē®)ŽäĒ Ž≥Ķžě°Ūēú ŪôėÍ≤Ş󟞥ú žěźžú®ž†ĀžúľŽ°ú žěĎŽŹôŪē† žąė žěąŽäĒ Žä•Ž†•žúľŽ°ú ÍĶ¨Ž≥ĄŽźėŽäĒ žßÄŽä•Ūėē žóźžĚīž†ĄŪäłžĚė Ūēú žĘÖŽ•ėžĚīŽč§. žóźžĚīž†ĄŪčĪ AI ŽŹĄÍĶ¨ŽäĒ žĹėŪÖźžł† žÉĚžĄĪŽ≥īŽč§ žĚėžā¨Í≤įž†ēžĚĄ žöįžĄ†žčúŪēėŽ©į, žĚłÍįĄžĚė ŪĒĄŽ°¨ŪĒĄŪ䳎āė žßÄžÜ枆ĀžĚł ÍįźŽŹÖžĚĄ žöĒÍĶ¨ŪēėžßÄ žēäŽäĒŽč§.[ 29]

žĚīŽď§žĚÄ Ž≥Ķžě°Ūēú Ž™©ŪĎú ÍĶ¨ž°į, žěźžóįžĖī žĚłŪĄįŪéėžĚīžä§, žā¨žö©žěź ÍįźŽŹÖ žóÜžĚī ŽŹÖŽ¶Ĺž†ĀžúľŽ°ú ŪĖČŽŹôŪē† žąė žěąŽäĒ Žä•Ž†•, žÜĆŪĒĄŪäłžõ®žĖī ŽŹĄÍĶ¨ ŽėźŽäĒ Í≥ĄŪöć žčúžä§ŪÖú ŪÜĶŪē©žĚĄ ŪŹ¨Ūē®Ūēú žó¨Žü¨ ÍįÄžßÄ ž£ľžöĒ žÜ枥ĪžĚĄ ÍįÄžßÄÍ≥† žěąŽč§. žĚīŽď§žĚė ž†úžĖī ŪĚźŽ¶ĄžĚÄ ŽĆÄŪėē žĖłžĖī Ž™®Žćł (LLM)žóź žĚėŪēī žěźž£ľ ÍĶ¨ŽŹôŽźúŽč§.[ 30]

žóįÍĶ¨žěźŽď§Í≥ľ ŪŹČŽ°†ÍįĎ吏ĚÄ AI žóźžĚīž†ĄŪäłÍįÄ ŪĎúž§ÄŪôĒŽźú ž†ēžĚėŽ•ľ ÍįÄžßÄÍ≥† žěąžßÄ žēäŽč§Í≥† žßÄž†ĀŪĖąŽč§.[ 30] [ 31] [ 32] [ 33]

AI žóźžĚīž†ĄŪäłžĚė žĚľŽįėž†ĀžĚł ž†Āžö©žĚÄ žā¨žö©žěź žöĒž≤≠žóź ŽĒįŽĚľ žó¨ŪĖČ Í≥ĄŪöćžĚĄ žėąžēĹŪēėŽäĒ Í≤ÉÍ≥ľ ÍįôžĚÄ žěĎžóÖ žěźŽŹôŪôĒžĚīŽč§.[ 34] [ 35] ŽćįŽĻą AI , Auto-GPT , SIMA ŽďĪžĚī žěąŽč§.[ 36] žė§ŪĒąAI žė§Ū澎†ąžĚīŪĄį ,[ 37] žĪóGPT ŽĒ• Ž¶¨žĄúžĻė ,[ 38] ŽßąŽąĄžä§ ,[ 39] Qwen ÍłįŽįė),[ 40] žė§Ū܆GLM Ž£®ŽĮłŽĄ§žĚīžÖė ,[ 40] ŽįĒžĚīŪ䳎ƥžä§ ).[ 40] Žě≠ž≤īžĚł ,[ 41] [ 42] [ 43] [ 44] žė§ŪĒąAI žä§žõú ŽďĪžĚī žěąŽč§.[ 45]

ÍĶ¨ÍłÄ , ŽßąžĚīŪĀ¨Ž°úžÜĆŪĒĄŪäł , žēĄŽßąž°ī žõĻ žĄúŽĻĄžä§ žôÄ ÍįôžĚÄ ŪöĆžā¨Žď§žĚÄ ŽĮłŽ¶¨ ÍĶ¨ž∂ēŽźú AI žóźžĚīž†ĄŪ䳎•ľ ŽįįŪŹ¨ ŪēėÍłį žúĄŪēú ŪĒĆŽěęŪŹľžĚĄ ž†úÍ≥ĶŪĖąŽč§.[ 46]

žóźžĚīž†ĄŪäł ÍįĄ ŪÜĶžč† ŪĎúž§ÄŪôĒŽ•ľ žúĄŪēú ž†úžēąŽźú ŪĒĄŽ°úŪ܆žĹúžóźŽäĒ žóźžĚīž†ĄŪäł ŪĒĄŽ°úŪ܆žĹú(Žě≠ž≤īžĚł), Ž™®Žćł žĽ®ŪÖćžä§Ūäł ŪĒĄŽ°úŪ܆žĹú (žē§Ū䳎°úŪĒĹ ), AGNTCY,[ 47] ÍłįŽ≤ĄŽßĀŪĀ¨ ,[ 48] [ 49] [ 50] [ 51] [ 52]

2025ŽÖĄ 2žõĒ, ŪóąÍĻÖ ŪéėžĚīžä§ ŽäĒ žė§ŪĒąAI ŽĒ• Ž¶¨žĄúžĻė žĚė žė§ŪĒą žÜĆžä§ Ž≤Ąž†ĄžĚł žė§ŪĒą ŽĒ• Ž¶¨žĄúžĻėŽ•ľ ž∂úžčúŪĖąŽč§.[ 53] žė§ŪĒąAI žė§Ū澎†ąžĚīŪĄį žôÄ žú†žā¨Ūēú Ž¨īŽ£Ć žõĻ ŽłĆŽĚľžöįž†Ä žóźžĚīž†ĄŪ䳎•ľ ž∂úžčúŪĖąŽč§.[ 54] [ 55]

2024ŽÖĄ ŽßźÍĻĆžßÄ ž∂úžčúŽźú 67Íįú žóźžĚīž†ĄŪäłžóź ŽĆÄŪēú ŽĻĄŪĒľžĖīŽ¶¨Ž∑į žóįÍĶ¨ ž°įžā¨ŽäĒ ŽĆÄŽ∂ÄŽ∂ĄžĚė žóźžĚīž†ĄŪäłÍįÄ ŽĮłÍĶ≠ ÍįúŽįúžěźžóź žĚėŪēī ÍłįžóÖžö©žúľŽ°ú ÍĶ¨ž∂ēŽźėžóąžúľŽ©į, žĹĒŽĒ© ŽėźŽäĒ žĽīŪď®ŪĄį žÉĀŪėłžěĎžö©žĚĄ Ž™©ž†ĀžúľŽ°ú ŪēėŽ©į, žĹĒŽďúŽāė Ž¨łžĄúŽ•ľ ÍįÄžßÄÍ≥† žěąžßÄŽßĆ žēąž†Ą ž†ēžĪÖžĚīŽāė ŪŹČÍįÄÍįÄ Ž∂Äž°ĪŪēėŽč§ŽäĒ žā¨žč§žĚĄ ŽįúÍ≤¨ŪĖąŽč§.[ 56]

CSIRO žóįÍĶ¨žõźŽď§žĚė ŽĻĄŪĒľžĖīŽ¶¨Ž∑į ŽÖľŽ¨łžĚÄ žÉĚžāįžóź žā¨žö©ŽźėŽäĒ žóźžĚīž†ĄŪ䳎•ľ Ž™®ŽčąŪĄįŽßĀ ŪēėÍłį žúĄŪēú žÜĆŪĒĄŪäłžõ®žĖī ŪĒĄŽ†ąžěĄžõĆŪĀ¨Ž•ľ ŽāėžóīŪēėÍ≥†, žóźžĚīž†ĄŪäłžėĶžä§ žôÄ ÍīÄŽ†®Žźú ÍįúŽÖź Ž∂ĄŽ•ėŽ•ľ ž†úžēąŪēúŽč§.[ 57]

ŪĆĆžĚīŽāłžÖú ŪÉÄžěĄžä§ ŽäĒ AI žóźžĚīž†ĄŪäłžĚė žěźžú®žĄĪžĚĄ žěźžú® ž£ľŪĖČ žěźŽŹôžį®žĚė SAE Ž∂ĄŽ•ė žôÄ ŽĻĄÍĶźŪēėŽ©į, ŽĆÄŽ∂ÄŽ∂ĄžĚė žĚĎžö© ŪĒĄŽ°úÍ∑łŽě®žĚī Ž†ąŽ≤® 2 ŽėźŽäĒ Ž†ąŽ≤® 3žóź ŪēīŽčĻŪēėÍ≥†, žĚľŽ∂ÄŽäĒ Í≥†ŽŹĄŽ°ú ž†ĄŽ¨łŪôĒŽźú žÉĀŪô©žóźžĄú Ž†ąŽ≤® 4Ž•ľ Žč¨žĄĪŪēėŽ©į, Ž†ąŽ≤® 5ŽäĒ žĚīŽ°†ž†ĀžĚīŽĚľÍ≥† ŽĻĄÍĶźŪĖąŽč§.[ 58]

ŽĆÄŪėē žĖłžĖī Ž™®Žćł(LLM) žôłžóźŽŹĄ ŽĻĄž†Ą žĖłžĖī Ž™®Žćł(VLM) ŽįŹ Ž©ÄŪčįŽ™®Žč¨ ÍłįŽįė Ž™®Žćł žĚÄ žóźžĚīž†ĄŪäłžĚė ÍłįŽįėžúľŽ°ú žā¨žö©Žź† žąė žěąŽč§. 2024ŽÖĄ 9žõĒ, žē®Žüį AI žóįÍĶ¨žÜĆ ŽäĒ žė§ŪĒą žÜĆžä§ ŽĻĄž†Ą žĖłžĖī Ž™®ŽćłžĚĄ ž∂úžčúŪĖąŽäĒŽćį, žôÄžĚīžĖīŽďú ŽäĒ žĚī Ž™®ŽćłžĚī AI žóźžĚīž†ĄŪäłžóź Ž≥Ķžě°Ūēú žĽīŪď®ŪĄį žěĎžó̥֞ žąėŪĖČŪē† žąė žěąŽäĒ Žä•Ž†•žĚĄ Ž∂Äžó¨Ūē† žąė žěąŽč§Í≥† žĖłÍłČŪĖąžúľŽ©į, žěźŽŹôŪôĒŽźú žĽīŪď®ŪĄį ŪēīŪāĻžĚė ÍįÄŽä•žĄĪŽŹĄ ŪŹ¨Ūē®ŽźúŽč§.[ 59] žóĒŽĻĄŽĒĒžēĄ ŽäĒ ÍįúŽįúžěźÍįÄ VLM, LLM ŽįŹ Í≤ÄžÉČž¶ĚÍįēžÉĚžĄĪ žĚĄ žā¨žö©Ūēėžó¨ žĚīŽĮłžßÄžôÄ ŽĻĄŽĒĒžė§ Ž•ľ Ž∂ĄžĄĚŪē† žąė žěąŽäĒ AI žóźžĚīž†ĄŪ䳎•ľ ÍĶ¨ž∂ēŪē† žąė žěąŽäĒ ŪĒĄŽ†ąžěĄžõĆŪĀ¨Ž•ľ ž∂úžčúŪĖąŽč§(ŽĻĄŽĒĒžė§ Í≤ÄžÉČ ŽįŹ ŽĻĄŽĒĒžė§ žöĒžēĹ ŪŹ¨Ūē®).[ 60] [ 61] žā¨žö©žěź žĚłŪĄįŪéėžĚīžä§ žÉĀŪėłžěĎžö© ŽįŹ Ž°úŽīáÍ≥ĶŪēô ŽćįžĚīŪĄįŽ°ú ŪõąŽ†®Žźú Ž©ÄŪčįŽ™®Žč¨ žóźžĚīž†ĄŪäł Ž™®ŽćłžĚĄ ž∂úžčúŪĖąžúľŽ©į, žĚī ŪöĆžā¨ŽäĒ žĚī Ž™®ŽćłžĚī žÜĆŪĒĄŪäłžõ®žĖī ŽįŹ Ž°úŽīá žĚĄ ž°įžěĎŪē† žąė žěąŽč§Í≥† ž£ľžě•ŪĖąŽč§.[ 62]

2025ŽÖĄ 4žõĒ ŪėĄžě¨, AP ŪÜĶžč† žóź ŽĒįŽ•īŽ©ī AI žóźžĚīž†ĄŪäłžĚė žč§ž†ú ž†Āžö© žā¨Ž°ÄŽäĒ ÍĪįžĚė žóÜŽč§.[ 63] ŪŹ¨ž∂ė žóź ŽĒįŽ•īŽ©ī ŽßéžĚÄ Íłįžó֎吏Ěī ž£ľŽ°ú AI žóźžĚīž†ĄŪ䳎•ľ žč§ŪóėŪēėÍ≥† žěąŽč§.[ 64]

ž†ēŽ∂ÄŪö®žú®Ž∂Ä žĚė Ūēú žĪĄžö© ŽčīŽčĻžěźŽäĒ 2025ŽÖĄ 4žõĒžóź žė§ŪĒąAI žĚė žěźÍłą žßÄžõźÍ≥ľ ŪĆĒŽěÄŪčįžĖī žôÄžĚė ŪĆĆŪ䳎Ąąžč≠ Í≥ĄžēŞ̥ ŪÜĶŪēī žä§ŪÉÄŪäłžóÖžĚė žĚľŪôėžúľŽ°ú AI žóźžĚīž†ĄŪ䳎•ľ žā¨žö©Ūēėžó¨ žēĹ 7ŽßĆ Ž™ÖžĚė ŽĮłÍĶ≠ žóįŽį© Í≥ĶŽ¨īžõź žóÖŽ¨īŽ•ľ žěźŽŹôŪôĒŪē† Í≤ɞ̥ ž†úžēąŪĖąŽč§. žĚī ž†úžēąžĚÄ Í∑ł ŽĻĄŪėĄžč§žĄĪ, žč¨žßÄžĖī Ž∂ąÍįÄŽä•žĄĪ, Í∑łŽ¶¨Í≥† Íłįžó֎吏Ěė ŪēīŽčĻ Ž∂ĄžēľžóźžĄúžĚė ÍīĎŽ≤ĒžúĄŪēú žĪĄŪÉĚ Ž∂Äž°ĪžúľŽ°ú žĚłŪēī ž†ĄŽ¨łÍįĎ吏Ěė ŽĻĄŪĆźžĚĄ ŽįõžēėŽč§.[ 65]

žėĻŪėłžěźŽď§žĚÄ AI žóźžĚīž†ĄŪäłÍįÄ ÍįúžĚł ŽįŹ Í≤Ĺž†ú žÉĚžāįžĄĪžĚĄ ŽÜížĚīÍ≥†,[ 35] [ 66] ŪėĀžč† žĚĄ žīȞߥŪēėŽ©į,[ 67] [ 67] [ 68] ŽłĒŽ£łŽ≤ĄÍ∑ł žĚė ŪĆĆŽĮł žė¨žä® žĚÄ žóźžĚīž†ĄŪäłÍįÄ ŽāģžĚÄ žúĄŪóėžĚė ŪėĎžÜĆŪēėÍ≥† ŽįėŽ≥Ķž†ĀžĚł žěĎžóÖžóź ÍįÄžě• ž†ĀŪē©ŪēėŽč§Í≥† ž£ľžě•ŪĖąŽč§.[ 69] žõĻ ž†ĎÍ∑ľžĄĪ žóź ž†Āžö©Žź† žąė žěąŽč§Í≥† ž†úžēąŪēėŽ©į,[ 70] [ 71] žě¨Žāú ŽĆÄžĚĎ Í≥ľ ÍįôžĚÄ žÉĀŪô©žóźžĄú žěźžõźžĚĄ ž°įžú®ŪēėŽäĒ Žćį žā¨žö©Žź† žąė žěąŽč§Í≥† ž†úžēąŪēúŽč§.[ 72] BBC žĚė R&D žěźŽ¨łŪĆÄžĚÄ AI žóźžĚīž†ĄŪäłÍįÄ Ūē†ŽčĻŽźú Ž™©ŪĎúÍįÄ Ž∂ąŪôēžč§Ūē† ŽēĆ ÍįÄžě• žú†žö©ŪēėŽč§Í≥† Ž≥łŽč§.[ 73]

žöįŽ†§ŽźėŽäĒ ž†źžúľŽ°úŽäĒ žě†žě¨ž†ĀžĚł žĪÖžěĄ Ž¨łž†ú,[ 66] [ 73] žā¨žĚīŽ≤Ą Ž≤Ēž£Ą ž¶ĚÍįÄ žúĄŪóė,[ 34] [ 66] žú§Ž¶¨ž†Ā Ž¨łž†ú ,[ 66] AI žēąž†Ą [ 66] AI ž†ēŽ†¨ ÍīÄŽ†® Ž¨łž†úŽŹĄ žěąŽč§.[ 34] [ 68] ŽćįžĚīŪĄį ŪĒĄŽĚľžĚīŽ≤Ąžčú ,[ 34] [ 74] [ 34] [ 66] [ 72] ŽįėŽ≥ĶžĄĪ Ž≥īžě• Ž∂Äž°Ī,[ 73] Ž≥īžÉĀ ŪēīŪāĻ ,[ 75] žēĆÍ≥†Ž¶¨ž¶ė ŪéłŪĖ• ,[ 74] [ 76] [ 34] [ 36] žĄ§Ž™Ö ÍįÄŽä•žĄĪ Ž∂Äž°Ī,[ 34] [ 77] Ž≥īžēą ž∑®žēĹž†ź ,[ 34] [ 78] Ž∂ąžôĄž†Ą Í≥†žö© Ž¨łž†ú,[ 76] žĚľžěźŽ¶¨ ŽĆÄž≤ī ,[ 35] [ 76] ž°įžěĎ ,[ 77] [ 79] žė§Ž≥ī [ 72] žēÖžĄĪ ž†ēŽ≥ī žĚė ÍįÄŽä•žĄĪ ŽďĪžĚī žěąŽč§.[ 72] žúĄŪóė ŪŹČÍįÄ Ž•ľ Ž≥Ķžě°ŪēėÍ≤Ć ŽßĆŽď§Í≥†, ŪôėÍįĀ žĚĄ ž°įžě•ŪēėŽ©į, Ž∂ąŽüČ žóźžĚīž†ĄŪäłžóź ŽĆÄŪēú ŽĆÄžĚĎžĪ̥֞ Žį©ŪēīŪēėÍ≥†, ŪĎúž§ÄŪôĒŽźú ŪŹČÍįÄ Žį©Ž≤ēžĚė Ž∂Äž°ĪžúľŽ°ú žĖīŽ†§žõĞ̥ Í≤™žĚĄ žąė žěąŽč§.[ 68] [ 80] [ 81] [ 30] [ 80] žĚłŪĄįŽĄ∑ Ū䳎ěėŪĒĹ žóź Ž∂Äž†ēž†ĀžĚł žėĀŪĖ•žĚĄ ŽĮłžĻėŽ©į,[ 80] ŪôėÍ≤Ĺ žóźŽŹĄ Ž∂Äž†ēž†ĀžĚł žėĀŪĖ•žĚĄ ŽĮłžĻ† žąė žěąŽč§ŽäĒ ŽĻĄŪĆźŽŹĄ žěąŽč§.[ 73] [ 82] [ 83] [ 75]

žĖłŽ°†žĚłŽď§žĚÄ AI žóźžĚīž†ĄŪ䳎•ľ ŽĻÖŪÖĆŪĀ¨ Íłįžó֎吏Ěī "Ž™®Žď† Í≤ɞ̥ žěźŽŹôŪôĒ"ŪēėŽ†§ŽäĒ žčúŽŹĄžĚė žĚľŽ∂ÄŽ°ú Ž¨ėžā¨ŪĖąŽč§.[ 84] [ 85] [ 86] žĻīŽĄ§Íłį Ž©úŽüį ŽĆÄŪēôÍĶź žóįÍĶ¨žõźŽď§žĚÄ žčúŽģ¨Ž†ąžĚīžÖėŽźú žÜĆŪĒĄŪäłžõ®žĖī ŪöĆžā¨žóźžĄú žóźžĚīž†ĄŪäłžĚė ŪĖČŽŹôžĚĄ ŪÖĆžä§ŪäłŪēú Í≤įÍ≥ľ, žĖīŽĖ§ žóźžĚīž†ĄŪ䳎ŹĄ Ūē†ŽčĻŽźú žěĎžóÖžĚė ŽĆĎ觞ąėŽ•ľ žôĄŽ£ĆŪē† žąė žó܎觎äĒ Í≤ɞ̥ ŽįúÍ≤¨ŪĖąŽč§.[ 85] [ 87] [ 88]

žöĒžäąžēĄ Ž≤§žßÄžė§ ŽäĒ 2025ŽÖĄ žĄłÍ≥Ą Í≤Ĺž†ú ŪŹ¨Žüľ žóźžĄú "AGI ŽėźŽäĒ žīąžßÄŽä• Í≥ľ ÍīÄŽ†®Žźú Ž™®Žď† žě¨žēôž†Ā žčúŽāėŽ¶¨žė§ ŽäĒ žóźžĚīž†ĄŪäłÍįÄ žěąžĚĄ ŽēĆ ŽįúžÉĚŪēúŽč§"Í≥† Í≤ĹÍ≥†ŪĖąŽč§.[ 89]

2025ŽÖĄ 3žõĒ, žä§žľÄžĚľ AI ŽäĒ ŽĮłÍĶ≠ ÍĶ≠Žį©Ž∂Ä žôÄ Í≥ĄžēŞ̥ ž≤īÍ≤įŪēėžó¨ žē§ŽćĒŽ¶ī žĚłŽćĒžä§Ū䳎¶¨ ŽįŹ ŽßąžĚīŪĀ¨Ž°úžÜĆŪĒĄŪäł žôÄ ŪėĎŽ†•Ūēėžó¨ ÍĶįžĚė "žěĎž†Ą žĚėžā¨Í≤įž†ē"žĚĄ žßÄžõźŪēėÍłį žúĄŪēú AI žóźžĚīž†ĄŪ䳎•ľ ÍįúŽįú ŽįŹ ŽįįžĻėŪēėÍłįŽ°ú ŪĖąŽč§.[ 90] žôłÍĶź ž†ēžĪÖ Í≤įž†ēžóź ŪéłŪĖ•Žź† žąė žěąŽč§Í≥† žöįŽ†§Ž•ľ ŪĎúŪĖąŽč§.[ 91] [ 92]

žóįÍĶ¨ ž§Ďžč¨ žóźžĚīž†ĄŪ䳎äĒ Í≥Ķžö© žĚłŪĄįŽĄ∑žóźžĄú žā¨žö© ÍįÄŽä•Ūēú ž†ēŽ≥īŽ•ľ žąėžßĎŪēėŽĮÄŽ°ú Ūē©žĚė ŪéłŪĖ• ŽįŹ Ž≤ĒžúĄ ŪéłŪĖ• žĚė žúĄŪóėžĚī žěąŽč§.[ 93] ŽČīžöē Žß§ÍĪįžßĄ žĚÄ žóźžĚīž†ĄŪäł ÍłįŽįė žõĻ ŽłĆŽĚľžöįž†ÄžĚė žā¨žö©žěź žõĆŪĀ¨ŪĒĆŽ°úžöįŽ•ľ žēĄŽßąž°ī žēĆŽ†Čžā¨ žôÄ Ž∂ąŽ¶¨ŪēėÍ≤Ć ŽĻĄÍĶźŪĖąŽäĒŽćį, žēĆŽ†Čžā¨ŽäĒ "žĚłÍįĄžĚī žÜĆŪĒĄŪäłžõ®žĖīžĚł ž≤ôŪēėŽ©į žÜĆŪĒĄŪäłžõ®žĖīŽ•ľ žā¨žö©ŪēėŽäĒ Í≤ÉžĚī žēĄŽčąŽĚľ žÜĆŪĒĄŪäłžõ®žĖīÍįÄ žÜĆŪĒĄŪäłžõ®žĖīžôÄ ŽĆÄŪôĒŪēėŽäĒ Í≤É"žĚīžóąŽč§.[ 94]

žóźžĚīž†ĄŪ䳎äĒ žė®ŽĚľžĚł žĹėŪÖźžł†Ž•ľ Í≤ĆžčúŪēėÍ≥† žįłžó¨Ūē† žąė žěąŽäĒ Žä•Ž†• ŽēĆŽ¨łžóź ž£ĹžĚÄ žĚłŪĄįŽĄ∑ žĚīŽ°† Í≥ľ žóįÍīÄŽźėžĖī žôĒŽč§.[ 95]

žóźžĚīž†ĄŪäłÍįÄ Ž¨īŪēú Ž£®ŪĒĄ žóź ŽĻ†žßą žąė žěąŽč§.[ 37] [ 96]

ŽßéžĚÄ žóźžĚīž†ĄŪäł ÍįĄ ŪĒĄŽ°úŪ܆žĹúžĚī ŽĆÄÍ∑úŽ™® Íłįžą† ÍłįžóÖžóź žĚėŪēī ÍįúŽįúŽźėÍ≥† žěąÍłį ŽēĆŽ¨łžóź, žĚīŽď§ ÍłįžóÖžĚī žĚīŽü¨Ūēú ŪĒĄŽ°úŪ܆žĹúžĚĄ žěźžā¨ žĚīžĚĶžĚĄ žúĄŪēī žā¨žö©Ūē† žąė žěąŽč§ŽäĒ žöįŽ†§ÍįÄ žěąŽč§.[ 51]

žßÄžĹĒ žĹúŪĄį ŽäĒ žóźžĚīž†ĄŪäł ÍįĄ žÉĀŪėł žěĎžö©žĚė Í≤įÍ≥ľŽ°ú ž†źžßĄž†Ā ŪĖČŽŹô žĚī ŽįúžÉĚŪē† ÍįÄŽä•žĄĪžĚĄ žĖłÍłČŪēėŽ©į, žĚīŽü¨Ūēú žÉĀŪėł žěĎžö©žĚė žúĄŪóėžĚĄ Ž™®ŽćłŽßĀŪēėÍłį žúĄŪēī Í≤ĆžěĄ žĚīŽ°† žóįÍĶ¨Ž•ľ ž†úžēąŪĖąŽč§.[ 97]

ŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ ÍįÄ "ž†ēŪôēŪēėžßÄ žēäžĚÄ žĹėŪÖźžł†Ž•ľ žčĚŽ≥ĄŪēėÍ≥† ž†úÍĪįŪēėŽäĒ Žćį žā¨žö©Žź† žąė žěąŽäĒ ŪēĄŪĄį, Í∑úžĻô ŽįŹ ŽŹĄÍĶ¨"Ž°ú ž†ēžĚėŪēú ÍįÄŽďúŽ†ąžĚľžĚÄ žė§Ž•ėŽ•ľ ž§ĄžĚīŽäĒ Žćį ŽŹĄžõÄžĚī Žź† žąė žěąŽč§Í≥† ž†úžēąŽźėžóąŽč§.[ 98]

ŽćįžĚīŪĄį ž†ĎÍ∑ľ Í≥ľ ÍīÄŽ†®Žźú Ž≥īžēą ž∑®žēĹž†źžĚĄ ŪēīÍ≤įŪēėÍłį žúĄŪēī žĖłžĖī Ž™®ŽćłžĚĄ žě¨žĄ§Í≥ĄŪēėžó¨ žßÄžĻ®Í≥ľ ŽćįžĚīŪĄįŽ•ľ Ž∂ĄŽ¶¨ŪēėÍĪįŽāė, žóźžĚīž†ĄŪäł žē†ŪĒĆŽ¶¨žľÄžĚīžÖėžóź ÍįÄŽďúŽ†ąžĚľžĚĄ ŪŹ¨Ūē®ŪēėŽŹĄŽ°Ě žöĒÍĶ¨Ūē† žąė žěąŽč§. žĚīŽü¨Ūēú žēĄžĚīŽĒĒžĖīŽäĒ ŽßąžĚīŪĀ¨Ž°úžÜĆŪĒĄŪäł 365 žĹĒŪĆƞ̾ŽüŅ žóź žėĀŪĖ•žĚĄ ŽĮłžĻú ž†úŽ°ú ŪĀīŽ¶≠ Í≥ĶÍ≤© žóź ŽĆÄŪēú ŽĆÄžĚĎžúľŽ°ú ž†úžēąŽźėžóąŽč§.[ 64]

žěźžú® ž£ľŪĖČ žěźŽŹôžį®Ž•ľ žúĄŪēú žóźžĚīž†ĄŪäł ÍłįŽįė Ž™®ŽćłŽßĀ ÍįúŽÖźžĚÄ 2003ŽÖĄ žĚľžįćžĚī ŽÖľžĚėŽźėžóąŽč§.[ 99]

Ūē†Žü¨ŽįĒŪĚź žôł žóįÍĶ¨žßĄžĚÄ žěźŽŹôŪôĒŽźú ž£ľŪĖČ žčúžä§ŪÖú ÍįúŽįú ŽįŹ Í≤Äž¶ĚžĚĄ žúĄŪēú žóźžĚīž†ĄŪäł ÍłįŽįė ž†ĎÍ∑ľ Žį©žč̞̥ ŪÉźÍĶ¨ŪĖąŽč§. Í∑łŽď§žĚė Žį©Ž≤ēžĚÄ ŪÖĆžä§Ūäł ŽĆÄžÉĀ žį®ŽüČžĚė ŽĒĒžßÄŪĄł ŪäłžúąÍ≥ľ ŽŹÖŽ¶Ĺ žóźžĚīž†ĄŪ䳎•ľ žā¨žö©Ūēú ŽĮłžĄł ÍĶźŪÜĶ žčúŽģ¨Ž†ąžĚīžÖėžĚĄ ŪŹ¨Ūē®ŪĖąŽč§.[ 100]

žõ®žĚīŽ™® ŽäĒ Ž¨īžĚł žěźŽŹôžį® žĚė žēĆÍ≥†Ž¶¨ž¶ėžĚĄ ŪÖĆžä§ŪäłŪēėÍłį žúĄŪēī žĻīŪĀ¨ŽěėŪĒĄŪ䳎̾ŽäĒ Žč§ž§Ď žóźžĚīž†ĄŪäł žčúŽģ¨Ž†ąžĚīžÖė ŪôėÍ≤Ş̥ ÍįúŽįúŪĖąŽč§.[ 101] [ 102]

žĄłžĚľž¶ąŪŹ¨žä§Žč∑žĽī žĚė žóźžĚīž†ĄŪäłŪŹ¨žä§ŽäĒ žěĎžó̥֞ žąėŪĖČŪēėŽäĒ žěźžú® žóźžĚīž†ĄŪäł ÍĶ¨ž∂ēžĚĄ Ūóąžö©ŪēėŽäĒ žóźžĚīž†ĄŪčĪ AI ŪĒĆŽěęŪŹľžĚīŽč§.[ 103] [ 104]

ÍĶźŪÜĶžēąž†Ąž≤≠ žĚÄ žÉĚž≤ī žĚłžčĚ ŽįŹ žā¨žßĄžĚĄ žā¨žö©Ūēėžó¨ žäĻÍįĚ žč†žõźžĚĄ žĚłž¶ĚŪēėŽäĒ ÍłįÍ≥Ą, Í∑łŽ¶¨Í≥† žā¨ÍĪī ŽĆÄžĚϞ̥ ŪŹ¨Ūē®Ūēú žÉąŽ°úžöī Íłįžą†žóź žóźžĚīž†ĄŪčĪ AIŽ•ľ ŪÜĶŪē©ŪēėÍ≥† žěąŽč§.[ 105]

‚ÜĎ Mukherjee, Anirban; Chang, Hannah (2025ŽÖĄ 2žõĒ 1žĚľ). „ÄäAgentic AI: Expanding the Algorithmic Frontier of Creative Problem Solving„Äč. SSRN 5123621 . ‚ÜĎ ÍįÄ Žāė Bringsjord, Selmer; Govindarajulu, Naveen Sundar (2018ŽÖĄ 7žõĒ 12žĚľ). „ÄąArtificial Intelligence„ÄČ . Edward N. Zalta. „ÄäThe Stanford Encyclopedia of Philosophy (Summer 2020 Edition)„Äč. ‚ÜĎ Wolchover, Natalie (2020ŽÖĄ 1žõĒ 30žĚľ). ‚ÄúArtificial Intelligence Will Do What We Ask. That's a Problem.‚ÄĚ . „ÄäQuanta Magazine„Äč (žėĀžĖī). 2020ŽÖĄ 6žõĒ 21žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Bull, Larry (1999). „ÄäOn model-based evolutionary computation„Äč. „ÄäSoft Computing„Äč 3 . 76‚Äď82ž™Ĺ. doi :10.1007/s005000050055 . S2CID 9699920 . ‚ÜĎ Lindenbaum, M., Markovitch, S., & Rusakov, D. (2004). Selective sampling for nearest neighbor classifiers. Machine learning, 54(2), 125‚Äď152.

‚ÜĎ ‚ÄúGenerative adversarial networks: What GANs are and how they've evolved‚ÄĚ . „ÄäVentureBeat„Äč. 2019ŽÖĄ 12žõĒ 26žĚľ. 2020ŽÖĄ 6žõĒ 18žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Wolchover, Natalie (January 2020). ‚ÄúArtificial Intelligence Will Do What We Ask. That's a Problem.‚ÄĚ . „ÄäQuanta Magazine„Äč (žėĀžĖī). 2020ŽÖĄ 6žõĒ 18žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Andrew Y. Ng, Daishi Harada, and Stuart Russell. "Policy invariance under reward transformations: Theory and application to reward shaping." In ICML, vol. 99, pp. 278-287. 1999.

‚ÜĎ ŽßąŪčī ŪŹ¨Žďú . Architects of Intelligence: The truth about AI from the people building it. Packt Publishing Ltd, 2018.‚ÜĎ ‚ÄúWhy AlphaZero's Artificial Intelligence Has Trouble With the Real World‚ÄĚ . „ÄäQuanta Magazine„Äč (žėĀžĖī). 2018. 2020ŽÖĄ 6žõĒ 18žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Adams, Sam; Arel, Itmar; Bach, Joscha; Coop, Robert; Furlan, Rod; Goertzel, Ben; Hall, J. Storrs; Samsonovich, Alexei; Scheutz, Matthias; Matthew; Stuart C.; John (2012ŽÖĄ 3žõĒ 15žĚľ). „ÄäMapping the Landscape of Human-Level Artificial General Intelligence„Äč. „ÄäAI Magazine„Äč 33 . 25ž™Ĺ. doi :10.1609/aimag.v33i1.2322 . ‚ÜĎ Hutson, Matthew (2020ŽÖĄ 5žõĒ 27žĚľ). ‚ÄúEye-catching advances in some AI fields are not real‚ÄĚ . „ÄäScience | AAAS„Äč (žėĀžĖī). 2020ŽÖĄ 6žõĒ 18žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Russell & Norvig 2003 , 33ž™Ĺ‚ÜĎ Salamon, Tomas (2011). „ÄäDesign of Agent-Based Models„Äč . Repin: Bruckner Publishing. 42‚Äď59ž™Ĺ. ISBN 978-80-904661-1-1 ‚ÜĎ Russell & Norvig 2003 , 46‚Äď54ž™Ĺ‚ÜĎ Thakur, Shreeya. ‚ÄúAI Agents: 5 Key Types Explained With Examples // Unstop‚ÄĚ . „Ääunstop.com„Äč (žėĀžĖī). 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúTypes of AI Agents | IBM‚ÄĚ . „Ääwww.ibm.com„Äč (žėĀžĖī). 2025ŽÖĄ 3žõĒ 17žĚľ. 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Stefano Albrecht and Peter Stone (2018). Autonomous Agents Modelling Other Agents: A Comprehensive Survey and Open Problems.

Artificial Intelligence, Vol. 258, pp. 66-95. https://doi.org/10.1016/j.artint.2018.01.002

‚ÜĎ ‚ÄúWhat is an AI agent? A computer scientist explains the next wave of artificial intelligence tools‚ÄĚ . „ÄäInverse„Äč (žėĀžĖī). 2024ŽÖĄ 12žõĒ 24žĚľ. 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Box, Geeks out of the (2019ŽÖĄ 12žõĒ 4žĚľ). ‚ÄúA Universal Formula for Intelligence‚ÄĚ . „ÄäGeeks out of the box„Äč (žėĀžĖī). 2022ŽÖĄ 10žõĒ 11žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Wissner-Gross, A. D.; Freer, C. E. (2013ŽÖĄ 4žõĒ 19žĚľ). „ÄäCausal Entropic Forces„Äč. „ÄäPhysical Review Letters„Äč 110 . 168702ž™Ĺ. Bibcode :2013PhRvL.110p8702W . doi :10.1103/PhysRevLett.110.168702 . hdl :1721.1/79750 . PMID 23679649 . ‚ÜĎ Poole, David; Mackworth, Alan. ‚Äú1.3 Agents Situated in Environments‚Ä£ Chapter 2 Agent Architectures and Hierarchical Control‚Ä£ Artificial Intelligence: Foundations of Computational Agents, 2nd Edition‚ÄĚ . „Ääartint.info„Äč. 2018ŽÖĄ 11žõĒ 28žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Fingar, Peter (2018). ‚ÄúCompeting For The Future With Intelligent Agents... And A Confession‚ÄĚ . „ÄäForbes Sites„Äč (žėĀžĖī). 2020ŽÖĄ 6žõĒ 18žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Burgin, Mark; Dodig-Crnkovic, Gordana (2009). ‚ÄúA Systematic Approach to Artificial Agents‚ÄĚ. arXiv :0902.3513 [cs.AI ]. ‚ÜĎ Purdy, Mark (2024ŽÖĄ 12žõĒ 12žĚľ). ‚ÄúWhat Is Agentic AI, and How Will It Change Work?‚ÄĚ . „ÄäHarvard Business Review„Äč (žėĀžĖī). ISSN 0017-8012 . 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ Kapoor, Sayash; Stroebl, Benedikt; Siegel, Zachary S.; Nadgir, Nitya; Narayanan, Arvind (2024). ‚ÄúAI Agents That Matter‚ÄĚ. arXiv :2407.01502 [cs.LG ]. ‚ÜĎ Zeff, Maxwell; Wiggers, Kyle (2025ŽÖĄ 3žõĒ 14žĚľ). ‚ÄúNo one knows what the hell an AI agent is‚ÄĚ . „ÄäŪÖĆŪĀ¨ŪĀ¨ŽüįžĻė „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 18žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Varanasi, Lakshmi. ‚ÄúAI agents are all the rage. But no one can agree on what they do.‚ÄĚ . „ÄäŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 11žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Bort, Julie (2025ŽÖĄ 5žõĒ 12žĚľ). ‚ÄúEven a16z VCs say no one really knows what an AI agent is‚ÄĚ . „ÄäŪÖĆŪĀ¨ŪĀ¨ŽüįžĻė „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 5žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ŽĚľ Žßą ŽįĒ žā¨ žēĄ ‚ÄúAI Agents: The Next Generation of Artificial Intelligence‚ÄĚ . „ÄäŽāīžÖĒŽĄź Ž°ú Ž¶¨Ž∑į „Äč (žėĀžĖī). 2024ŽÖĄ 12žõĒ 30žĚľ. 2025ŽÖĄ 1žõĒ 11žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ‚ÄúWhat are the risks and benefits of 'AI agents'?‚ÄĚ . „Ä䞥łÍ≥Ą Í≤Ĺž†ú ŪŹ¨Žüľ „Äč (žėĀžĖī). 2024ŽÖĄ 12žõĒ 16žĚľ. 2024ŽÖĄ 12žõĒ 28žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Knight, Will (2024ŽÖĄ 3žõĒ 14žĚľ). ‚ÄúForget Chatbots. AI Agents Are the Future‚ÄĚ . „ÄäžôÄžĚīžĖīŽďú „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 1059-1028 . 2025ŽÖĄ 1žõĒ 5žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Marshall, Matt (2025ŽÖĄ 2žõĒ 22žĚľ). ‚ÄúThe rise of browser-use agents: Why Convergence's Proxy is beating OpenAI's Operator‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 2žõĒ 22žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Milmo, Dan (2025ŽÖĄ 2žõĒ 3žĚľ). ‚ÄúOpenAI launches 'deep research' tool that it says can match research analyst‚ÄĚ . „ÄäÍįÄŽĒĒžĖł „Äč (žėĀÍĶ≠ žėĀžĖī). ISSN 0261-3077 . 2025ŽÖĄ 2žõĒ 3žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Chen, Caiwei (2025ŽÖĄ 3žõĒ 11žĚľ). ‚ÄúEveryone in AI is talking about Manus. We put it to the test.‚ÄĚ . „ÄäMIT ŪÖĆŪĀ¨ŽÜÄŽ°úžßÄ Ž¶¨Ž∑į „Äč (žėĀžĖī). 2025ŽÖĄ 3žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ‚ÄúChina is gaining ground in the global race to develop AI agents‚ÄĚ . „Ä䞥łÍ≥ĄžĚė ŽāėŽ®łžßÄ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 6žõĒ 2žĚľ. 2025ŽÖĄ 6žõĒ 2žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ David, Emilia (2024ŽÖĄ 12žõĒ 30žĚľ). ‚ÄúWhy 2025 will be the year of AI orchestration‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2024ŽÖĄ 12žõĒ 30žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúCAMEL: Finding the Scaling Law of Agents. The first and the best multi-agent framework.‚ÄĚ . „ÄäÍĻÉŪóąŽłĆ „Äč. ‚ÜĎ Li, Guohao (2023). „ÄäCamel: Communicative agents for "mind" exploration of large language model society„Äč (PDF) . „ÄäAdvances in Neural Information Processing Systems„Äč 36 . 51991‚Äď52008ž™Ĺ. arXiv :2303.17760 . S2CID 257900712 . ‚ÜĎ Dickson, Ben (2023ŽÖĄ 10žõĒ 3žĚľ). ‚ÄúMicrosoft's AutoGen framework allows multiple AI agents to talk to each other and complete your tasks‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2024ŽÖĄ 12žõĒ 27žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúThe next AI wave ‚ÄĒ agents ‚ÄĒ should come with warning labels‚ÄĚ . „Ä䞼īŪď®ŪĄįžõĒŽďú „Äč (žėĀžĖī). 2025ŽÖĄ 1žõĒ 13žĚľ. 2025ŽÖĄ 1žõĒ 14žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ David, Emilia (2025ŽÖĄ 4žõĒ 15žĚľ). ‚ÄúMoveworks joins AI agent library craze‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 15žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ David, Emilia (2025ŽÖĄ 3žõĒ 6žĚľ). ‚ÄúA standard, open framework for building AI agents is coming from Cisco, LangChain and Galileo‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 9žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Zeff, Maxwell (2025ŽÖĄ 3žõĒ 5žĚľ). ‚ÄúGibberLink lets AI agents call each other in robo-language‚ÄĚ . „ÄäŪÖĆŪĀ¨ŪĀ¨ŽüįžĻė „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 5žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Cooney, Michael (2025ŽÖĄ 1žõĒ 30žĚľ). ‚ÄúCisco touts 'Internet of Agents' for secure AI agent collaboration‚ÄĚ . „Ä䎥§ŪäłžõĆŪĀ¨ žõĒŽďú „Äč (žėĀžĖī). 2025ŽÖĄ 1žõĒ 31žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Clark, Lindsay (2025ŽÖĄ 4žõĒ 10žĚľ). ‚ÄúDid someone say AI agents, Google asks, bursting in‚ÄĚ . „ÄäŽćĒ Ž†ąžßÄžä§ŪĄį „Äč. 2025ŽÖĄ 4žõĒ 10žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Stokel-Walker, Chris (2025ŽÖĄ 6žõĒ 11žĚľ). ‚ÄúCan we stop big tech from controlling the internet with AI agents?‚ÄĚ . „ÄäŽČī žā¨žĚīžĖłŪčįžä§Ūäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 6žõĒ 11žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ David, Emilia (2025ŽÖĄ 3žõĒ 28žĚľ). ‚ÄúNew approach to agent reliability, AgentSpec, forces agents to follow rules‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Edwards, Benj (2025ŽÖĄ 2žõĒ 5žĚľ). ‚ÄúHugging Face clones OpenAI's Deep Research in 24 hours‚ÄĚ . „ÄäžēĄŽ•īžä§ ŪÖĆŪĀ¨ŽčąžĻī „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 2žõĒ 6žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Wiggers, Kyle (2025ŽÖĄ 5žõĒ 6žĚľ). ‚ÄúHugging Face releases a free Operator-like agentic AI tool‚ÄĚ . „ÄäŪÖĆŪĀ¨ŪĀ¨ŽüįžĻė „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 5žõĒ 6žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Ortiz, Sabrina (2025ŽÖĄ 2žõĒ 14žĚľ). ‚ÄúWhich AI agent is the best? This new leaderboard can tell you‚ÄĚ . „ÄäžßÄŽĒĒŽĄ∑ „Äč (žėĀžĖī). 2025ŽÖĄ 3žõĒ 30žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Casper, Stephen; Bailey, Luke; Hunter, Rosco; Ezell, Carson; Cabal√©, Emma; Gerovitch, Michael; Slocum, Stewart; Wei, Kevin; Jurkovic, Nikola; Khan, Ariba; Christoffersen, Phillip J. K.; Pinar Ozisik, A.; Trivedi, Rakshit; Dylan; Kolt, Noam (2025). ‚ÄúThe AI Agent Index‚ÄĚ. arXiv :2502.01635 [cs.SE ]. ‚ÜĎ Dong, Liming; Lu, Qinghua; Zhu, Liming (2024). ‚ÄúAgentOps: Enabling Observability of LLM Agents‚ÄĚ. arXiv :2411.05285 [cs.AI ]. ‚ÜĎ Colback, Lucy (2025ŽÖĄ 5žõĒ 7žĚľ). ‚ÄúAI agents: from co-pilot to autopilot‚ÄĚ . „ÄäŪĆĆžĚīŽāłžÖú ŪÉÄžěĄžä§ „Äč. 2025ŽÖĄ 5žõĒ 7žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Knight, Will (2024ŽÖĄ 9žõĒ 25žĚľ). ‚ÄúThe Most Capable Open Source AI Model Yet Could Supercharge AI Agents‚ÄĚ . „ÄäžôÄžĚīžĖīŽďú „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 1059-1028 . 2025ŽÖĄ 3žõĒ 28žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Takahashi, Dean (2024ŽÖĄ 11žõĒ 4žĚľ). ‚ÄúNvidia AI Blueprint makes it easy for any devs to build automated agents that analyze video‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2024ŽÖĄ 12žõĒ 5žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Takahashi, Dean (2025ŽÖĄ 1žõĒ 7žĚľ). ‚ÄúNvidia launches blueprint for AI agents that can analyze video‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 4žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Edwards, Benj (2025ŽÖĄ 2žõĒ 20žĚľ). ‚ÄúMicrosoft‚Äôs new AI agent can control software and robots‚ÄĚ . „ÄäžēĄŽ•īžä§ ŪÖĆŪĀ¨ŽčąžĻī „Äč (žėĀžĖī). 2025ŽÖĄ 5žõĒ 20žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúVisa wants to give artificial intelligence 'agents' your credit card‚ÄĚ . „ÄäAP „Äč (žėĀžĖī). 2025ŽÖĄ 4žõĒ 30žĚľ. 2025ŽÖĄ 5žõĒ 1žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Goldman, Sharon (2025ŽÖĄ 6žõĒ 11žĚľ). ‚ÄúMicrosoft Copilot flaw raises urgent questions for any business deploying AI agents‚ÄĚ . „ÄäŪŹ¨ž∂ė „Äč (žėĀžĖī). 2025ŽÖĄ 6žõĒ 11žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Haskins, Caroline (2025ŽÖĄ 5žõĒ 2žĚľ). ‚ÄúA DOGE Recruiter Is Staffing a Project to Deploy AI Agents Across the US Government‚ÄĚ . „ÄäžôÄžĚīžĖīŽďú „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 1059-1028 . 2025ŽÖĄ 5žõĒ 3žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ŽĚľ Žßą ŽįĒ Piper, Kelsey (2024ŽÖĄ 3žõĒ 29žĚľ). ‚ÄúAI "agents" could do real work in the real world. That might not be a good thing.‚ÄĚ . „ÄäŽ≥Ķžä§ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2024ŽÖĄ 12žõĒ 19žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Purdy, Mark (2024ŽÖĄ 12žõĒ 12žĚľ). ‚ÄúWhat Is Agentic AI, and How Will It Change Work?‚ÄĚ . „ÄäŪēėŽ≤ĄŽďú ŽĻĄž¶ąŽčąžä§ Ž¶¨Ž∑į „Äč. ISSN 0017-8012 . 2024ŽÖĄ 12žõĒ 30žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 20žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ Wright, Webb (2024ŽÖĄ 12žõĒ 12žĚľ). ‚ÄúAI Agents with More Autonomy Than Chatbots Are Coming. Some Safety Experts Are Worried‚ÄĚ . „Ääžā¨žĚīžĖłŪčįŪĒĹ žēĄŽ©ĒŽ¶¨žĻł „Äč (žėĀžĖī). 2024ŽÖĄ 12žõĒ 23žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Olson, Parmy (2025ŽÖĄ 1žõĒ 27žĚľ). ‚ÄúSkip the Hype, Here's How AI 'Agents' Can Really Help‚ÄĚ . „Ä䎳ĒŽ£łŽ≤ĄÍ∑ł ŽČīžä§ „Äč. 2025ŽÖĄ 1žõĒ 27žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Deng, Xiang; Gu, Yu; Zheng, Boyuan; Chen, Shijie; Stevens, Samuel; Wang, Boshi; Sun, Huan; Su, Yu (2023). ‚ÄúMind2Web: Towards a Generalist Agent for the Web‚ÄĚ. arXiv :2306.06070 [cs.CL ]. ‚ÜĎ Woodall, Tatyana (2024ŽÖĄ 1žõĒ 9žĚľ). ‚ÄúResearchers developing AI to make the internet more accessible‚ÄĚ . „Ääžė§ŪēėžĚīžė§ ž£ľŽ¶Ĺ ŽČīžä§ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 28žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ŽĚľ Mitchell, Margaret ; Ghosh, Avijit; Luccioni, Sasha ; Pistilli, Giada (2025ŽÖĄ 3žõĒ 24žĚľ). ‚ÄúWhy handing over total control to AI agents would be a huge mistake‚ÄĚ . „ÄäMIT ŪÖĆŪĀ¨ŽÜÄŽ°úžßÄ Ž¶¨Ž∑į „Äč (žėĀžĖī). 2025ŽÖĄ 3žõĒ 24žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ŽĚľ ‚ÄúAI agents: Exploring the potential and the problems‚ÄĚ . „ÄäBBC žė®ŽĚľžĚł „Äč (žėĀÍĶ≠ žėĀžĖī). 2025ŽÖĄ 5žõĒ 30žĚľ. 2025ŽÖĄ 6žõĒ 10žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė O'Neill, Brian (2024ŽÖĄ 12žõĒ 18žĚľ). ‚ÄúWhat is an AI agent? A computer scientist explains the next wave of artificial intelligence tools‚ÄĚ . „ÄäŽĆÄŪôĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 1žõĒ 4žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Huckins, Grace (2025ŽÖĄ 6žõĒ 12žĚľ). ‚ÄúAre we ready to hand AI agents the keys?‚ÄĚ . „ÄäMIT ŪÖĆŪĀ¨ŽÜÄŽ°úžßÄ Ž¶¨Ž∑į „Äč (žėĀžĖī). 2025ŽÖĄ 6žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ Lin, Belle (2025ŽÖĄ 1žõĒ 6žĚľ). ‚ÄúHow Are Companies Using AI Agents? Here's a Look at Five Early Users of the Bots‚ÄĚ . „ÄäžõĒžä§Ū䳎¶¨Ūäł ž†ÄŽĄź „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 0099-9660 . 2025ŽÖĄ 1žõĒ 6žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 20žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Zittrain, Jonathan L. (2024ŽÖĄ 7žõĒ 2žĚľ). ‚ÄúWe Need to Control AI Agents Now‚ÄĚ . „ÄäŽĒĒ žē†ŪčÄŽěúŪčĪ „Äč (žėĀžĖī). 2024ŽÖĄ 12žõĒ 31žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 20žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Kerner, Sean Michael (2025ŽÖĄ 1žõĒ 16žĚľ). ‚ÄúNvidia tackles agentic AI safety and security with new NeMo Guardrails NIMs‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 1žõĒ 16žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 20žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Crawford, Kate (2024ŽÖĄ 12žõĒ 23žĚľ). ‚ÄúAI Agents Will Be Manipulation Engines‚ÄĚ . „ÄäžôÄžĚīžĖīŽďú „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 1059-1028 . 2025ŽÖĄ 1žõĒ 3žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ÍįÄ Žāė Žč§ ‚ÄúThe argument against AI agents and unnecessary automation‚ÄĚ . „ÄäŽćĒ Ž†ąžßÄžä§ŪĄį „Äč. 2025ŽÖĄ 1žõĒ 27žĚľ. 2025ŽÖĄ 1žõĒ 27žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 1žõĒ 30žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Blackman, Reid (2025ŽÖĄ 6žõĒ 13žĚľ). ‚ÄúOrganizations Aren‚Äôt Ready for the Risks of Agentic AI‚ÄĚ . „ÄäŪēėŽ≤ĄŽďú ŽĻĄž¶ąŽčąžä§ Ž¶¨Ž∑į „Äč (žėĀžĖī). ISSN 0017-8012 . 2025ŽÖĄ 6žõĒ 13žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúWe did the math on AI‚Äôs energy footprint. Here‚Äôs the story you haven‚Äôt heard.‚ÄĚ . „ÄäMIT ŪÖĆŪĀ¨ŽÜÄŽ°úžßÄ Ž¶¨Ž∑į „Äč (žėĀžĖī). 2025ŽÖĄ 5žõĒ 20žĚľ. 2025ŽÖĄ 5žõĒ 20žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . We started small, as the question of how much a single query costs is vitally important to understanding the bigger picture. That's because those queries are being built into ever more applications beyond standalone chatbots: from search, to agents, to the mundane daily apps we use to track our fitness, shop online, or book a flight. The energy resources required to power this artificial-intelligence revolution are staggering, and the world's biggest tech companies have made it a top priority to harness ever more of that energy, aiming to reshape our energy grids in the process. ‚ÜĎ ‚ÄúInside the effort to tally AI‚Äôs energy appetite‚ÄĚ . „ÄäMIT ŪÖĆŪĀ¨ŽÜÄŽ°úžßÄ Ž¶¨Ž∑į „Äč (žėĀžĖī). 2025ŽÖĄ 6žõĒ 3žĚľ. 2025ŽÖĄ 6žõĒ 3žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 12žĚľžóź ŪôēžĚłŪē® . Lots of AI companies are building reasoning models, which "think" for longer and use more energy. They're building hardware devices, perhaps like the one Jony Ive has been working on (which OpenAI just acquired for $6.5 billion), that have AI constantly humming along in the background of our conversations. They're designing agents and digital clones of us to act on our behalf. All these trends point to a more energy-intensive future (which, again, helps explain why OpenAI and others are spending such inconceivable amounts of money on energy). ‚ÜĎ Wong, Matteo (2025ŽÖĄ 3žõĒ 14žĚľ). ‚ÄúWas Sam Altman Right About the Job Market?‚ÄĚ . „ÄäŽĒĒ žē†ŪčÄŽěúŪčĪ „Äč (žėĀžĖī). 2025ŽÖĄ 3žõĒ 17žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . In other words, flawed products won't stop tech companies' push to automate everything‚ÄĒthe AI-saturated future will be imperfect at best, but it is coming anyway. ‚ÜĎ ÍįÄ Žāė Agarwal, Shubham. ‚ÄúCarnegie Mellon staffed a fake company with AI agents. It was a total disaster.‚ÄĚ . „ÄäŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 28žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Sabin, Sam (2025ŽÖĄ 4žõĒ 22žĚľ). ‚ÄúExclusive: Anthropic warns fully AI employees are a year away‚ÄĚ . „Ääžē°žčúžė§žä§ „Äč (žėĀžĖī). 2025ŽÖĄ 4žõĒ 23žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Xu, Frank F.; Song, Yufan; Li, Boxuan; Tang, Yuxuan; Jain, Kritanjali; Bao, Mengxue; Wang, Zora Z.; Zhou, Xuhui; Guo, Zhitong; Cao, Murong; Yang, Mingyang; Hao Yang Lu; Martin, Amaad; Su, Zhe; Maben, Leander; Mehta, Raj; Chi, Wayne; Jang, Lawrence; Xie, Yiqing; Zhou, Shuyan; Neubig (2024). ‚ÄúTheAgentCompany: Benchmarking LLM Agents on Consequential Real World Tasks‚ÄĚ. arXiv :2412.14161 [cs.CL ]. ‚ÜĎ Claburn, Thomas (2025ŽÖĄ 1žõĒ 23žĚľ). ‚ÄúTool touted as 'first AI software engineer' is bad at its job, testers claim‚ÄĚ . „ÄäŽćĒ Ž†ąžßÄžä§ŪĄį „Äč. 2025ŽÖĄ 3žõĒ 30žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 6žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Balevic, Katie. ‚ÄúSignal president warns the hyped agentic AI bots threaten user privacy‚ÄĚ . „ÄäŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Hornstein, Julia. ‚ÄúAI agents are coming to the military. VCs love it, but researchers are a bit wary.‚ÄĚ . „ÄäŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 12žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Tangermann, Victor (2025ŽÖĄ 3žõĒ 6žĚľ). ‚ÄúPentagon Signs Deal to "Deploy AI Agents for Military Use" ‚ÄĚ . „ÄäŪﮞ≤ėŽ¶¨ž¶ė „Äč. 2025ŽÖĄ 3žõĒ 8žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Jensen, Benjamin (2025ŽÖĄ 3žõĒ 4žĚľ). ‚ÄúThe Troubling Truth About How AI Agents Act in a Crisis‚ÄĚ . „ÄäŪŹ¨Ž¶į ŪŹīŽ¶¨žčú „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 4žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Nu√Īez, Michael (2025ŽÖĄ 2žõĒ 25žĚľ). ‚ÄúOpenAI expands Deep Research access to Plus users, heating up AI agent wars with DeepSeek and Claude‚ÄĚ . „ÄäŽ≤§ž∂ĒžĖīŽĻĄŪäł „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 3žõĒ 11žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Herrman, John (2025ŽÖĄ 1žõĒ 25žĚľ). ‚ÄúWhat Are AI 'Agents' For?‚ÄĚ . „ÄäžĚłŪÖĒŽ¶¨ž††žĄú „Äč (žėĀžĖī). 2025ŽÖĄ 1žõĒ 25žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Caramela, Sammi (2025ŽÖĄ 2žõĒ 1žĚľ). ‚Äú' Dead Internet Theory' Is Back Thanks to All of That AI Slop‚ÄĚ . „ÄäŽįĒžĚīžä§ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 2žõĒ 1žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Metz, Cade; Weise, Karen (2023ŽÖĄ 10žõĒ 16žĚľ). ‚ÄúHow 'A.I. Agents' That Roam the Internet Could One Day Replace Workers‚ÄĚ . „ÄäŽČīžöē ŪÉÄžěĄžä§ „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 0362-4331 . 2023ŽÖĄ 12žõĒ 19žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 4žõĒ 2žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Knight, Will (2025ŽÖĄ 4žõĒ 9žĚľ). ‚ÄúThe AI Agent Era Requires a New Kind of Game Theory‚ÄĚ . „ÄäžôÄžĚīžĖīŽďú „Äč (ŽĮłÍĶ≠ žėĀžĖī). ISSN 1059-1028 . 2025ŽÖĄ 4žõĒ 9žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Varanasi, Lakshmi. ‚ÄúDon't get too excited about AI agents yet. They make a lot of mistakes.‚ÄĚ . „ÄäŽĻĄž¶ąŽčąžä§ žĚłžā¨žĚīŽćĒ „Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 18žĚľžóź žõźŽ≥ł Ž¨łžĄú žóźžĄú Ž≥īž°īŽźú Ž¨łžĄú. 2025ŽÖĄ 5žõĒ 15žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Yang, Guoqing; Wu, Zhaohui; Li, Xiumei; Chen, Wei (2003). „ÄąSVE: embedded agent-based smart vehicle environment„ÄČ . „ÄäProceedings of the 2003 IEEE International Conference on Intelligent Transportation Systems„Äč. 1745‚Äď1749ž™Ĺ. doi :10.1109/ITSC.2003.1252782 . ISBN 0-7803-8125-4 S2CID 110177067 . ‚ÜĎ Hallerbach, S.; Xia, Y.; Eberle, U.; Koester, F. (2018). „ÄäSimulation-Based Identification of Critical Scenarios for Cooperative and Automated Vehicles„Äč . „ÄäSAE International Journal of Connected and Automated Vehicles„Äč 1 (SAE International). 93ž™Ĺ. doi :10.4271/2018-01-1066 . ‚ÜĎ Madrigal, Story by Alexis C. ‚ÄúInside Waymo's Secret World for Training Self-Driving Cars‚ÄĚ . „ÄäThe Atlantic„Äč. 2020ŽÖĄ 8žõĒ 14žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ Connors, J.; Graham, S.; Mailloux, L. (2018). „ÄäCyber Synthetic Modeling for Vehicle-to-Vehicle Applications„Äč. „ÄäIn International Conference on Cyber Warfare and Security„Äč (Academic Conferences International Limited). 594-XIž™Ĺ. ‚ÜĎ Nu√Īez, Michael (2025ŽÖĄ 3žõĒ 5žĚľ). ‚ÄúSalesforce launches Agentforce 2dx, letting AI run autonomously across enterprise systems‚ÄĚ . „ÄäVentureBeat„Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúSalesforce unveils Agentforce to help create autonomous AI bots‚ÄĚ . „ÄäCIO„Äč (žėĀžĖī). 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® . ‚ÜĎ ‚ÄúTSA Showcase Biometric AI-powered Airport Immigration Security‚ÄĚ . „Äätechinformed.com„Äč (ŽĮłÍĶ≠ žėĀžĖī). 2025ŽÖĄ 1žõĒ 23žĚľ. 2025ŽÖĄ 4žõĒ 24žĚľžóź ŪôēžĚłŪē® .